近日,Facebook 公布了一项名为 Ego4D 的研究项目。该项目为 Facebook 与全球 13 所大学和实验室合作项目,通过收集第一人称镜头,以训练下一代人工智能模型。

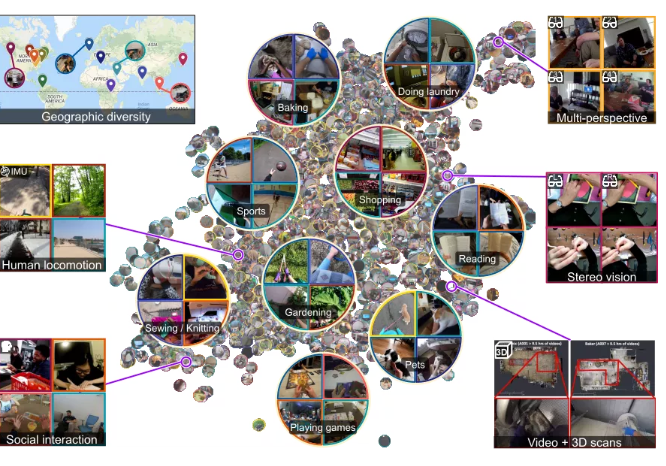

信息显示,Ego4D 数据集包含超过 3025 个小时的视频,由来自 9 个国家(美国、英国、印度、日本、意大利、新加坡、沙特阿拉伯、哥伦比亚和卢旺达)73 个不同地点录制的视频组成,总录制人数达 855 人。据了解,这些参与者拥有不同的年龄和背景,有些人是因其有趣的职业而被招募过来,例如面包师、机械师、木匠和园艺师。

这也是目前最大的第一视角日常活动视频数据集,在此之前,最大的第一视角视频数据集由人在厨房里 100 个小时的镜头组成。此外,以前的数据集通常由只有几秒钟的半脚本视频剪辑组成,而 Ego4D 的参与者一次佩戴头戴式摄像头长达 10 小时,并拍摄无脚本日常活动的第一人称视频,包括沿街散步、阅读、洗衣、购物、与宠物玩耍、玩棋盘游戏和与其他人互动。一些镜头还包括音频、有关参与者注视焦点位置的数据以及同一场景的多个视角。

收集到视频后,卢旺达的工作人员总共花费了 25 万个小时观看数千个视频剪辑,并编写数百万个描述拍摄场景和活动的句子。这些视频能够帮助人工智能理解或识别现实世界或虚拟世界中的某些事物,人类也可以通过一副眼镜或 Oculus 耳机从第一人称视角看到这些事物。

纽约石溪大学和谷歌大脑的计算机视觉研究员 Michael Ryoo 表示:“这个数据集里的视频更接近人类所观察的世界,这在同类数据集中是第一个。”

论文链接:https://arxiv.org/abs/2110.07058

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢