GNN在NLP中的研究:

【TACL 2020】AMR-To-Text Generation with Graph Transformer

文章作者:Tianming Wang, Xiaojun Wan, Hanqi Jin

文章地址:https://aclanthology.org/2020.tacl-1.2.pdf

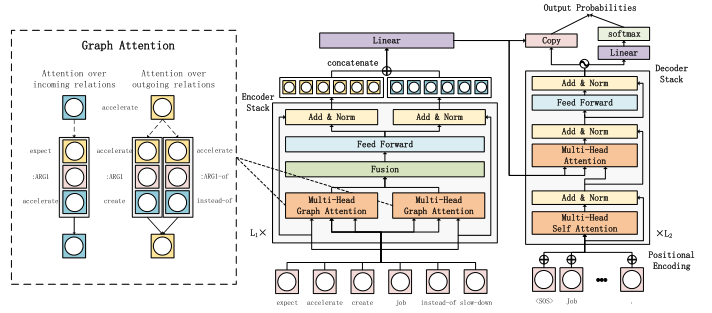

文章导读:文章作者来自北京大学万小军老师团队。本文研究的是抽象意义表示AMR到文本生成的工作,AMR图节点表示概念,边表示关系。当前最先进的方法使用图形对模型进行排序;然而,它们仍然不能显著优于先前的seq2seq模型或统计方法。文章提出了一种新的图到序列模型(Graph Transformer)来解决这个问题。该模型直接编码AMR图并学习节点表示。使用成对交互函数计算概念之间的语义关系。此外,注意机制用于聚合来自传入和传出邻居的信息,这有助于模型有效地捕获语义信息。

左: Graph attention mechanism.右:The overall architecture of Graph Transformer.

【2021 ACL】Compare to The Knowledge: Graph Neural Fake News Detection with External Knowledge

文章作者:Linmei Hu, Tianchi Yang, Luhao Zhang, Wanjun Zhong, Duyu Tang, Chuan Shi, Nan Duan, Ming Zhou

文章地址:https://aclanthology.org/2021.acl-long.62.pdf

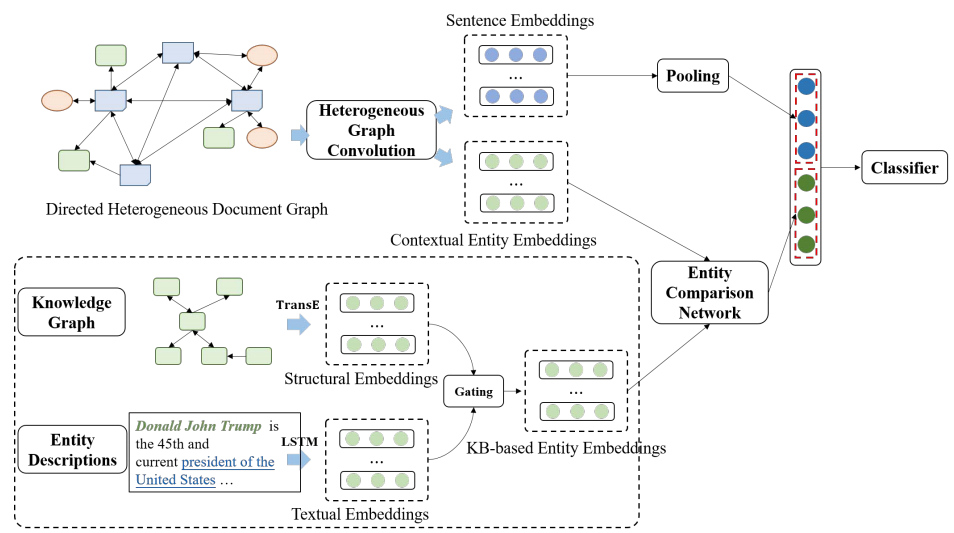

文章导读:文章作者来自北京邮电大学和微软亚洲研究院。本文关注假新闻检测问题,提出利用知识图谱的信息来辅助假新闻文本的检测。作者首先对新闻文本中的句子,主题和实体构建一个有向异构图,并通过异构图注意力网络进行学习,分别得到新闻文本节点表示和新闻中实体节点表示。然后将新闻中的实体节点表示与相应的知识图谱中学到的实体节点表示进行一致性比较后联合文本节点表示做假新闻检测。

CompareNet

GNN在推荐系统中的研究:

【TKDE 2021】 Hierarchical User Intent Graph Network for Multimedia Recommendation

文章作者:Yinwei Wei , Xiang Wang , Xiangnan He , Liqiang Nie , Yong Rui , Tat-Seng Chua

文章链接:https://arxiv.org/pdf/2110.14925v1.pdf

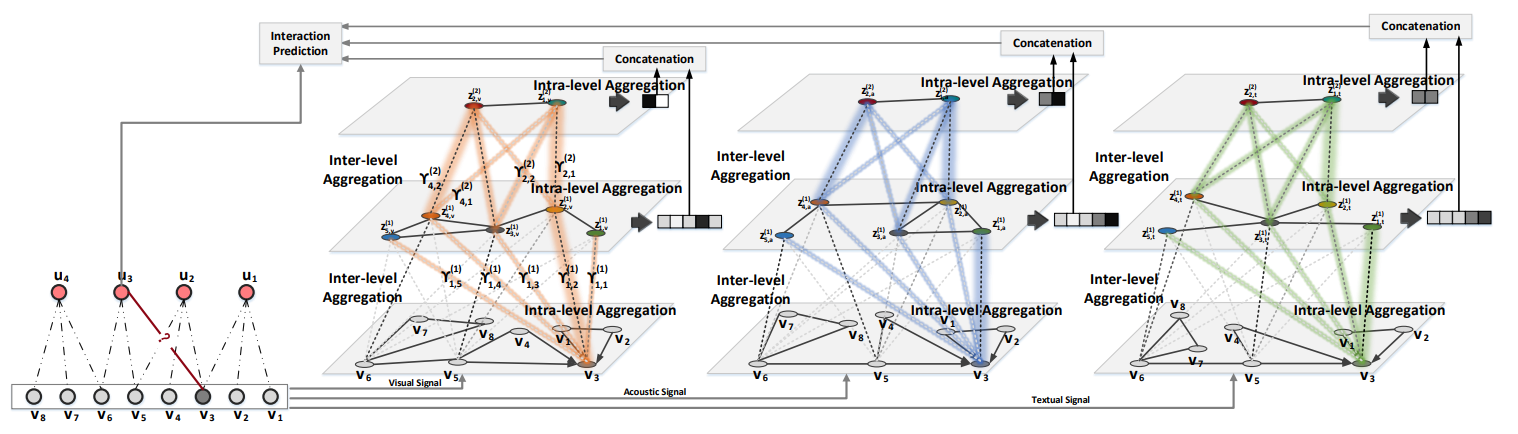

文章导读:本文由新加坡国立大学和中科大的何向南老师等完成。文章关注的场景是多媒体推荐场景。了解用户对项目上下文的偏好是获得高质量多媒体推荐的关键。通常,对于物品会通过预训练模型提出表征,引入推荐系统中以捕获用户偏好。然而,作者认为这样的方式无法输出有效的用户表示,这很难很好地描述个人兴趣。关键原因是目前的方法在很大程度上保持用户意图不变,未能对用户的信息表示进行编码。在本文中,作者的目标是从物品的交互模式中学习多层次的用户意图,以获得高质量的用户和物品的表示,并进一步提高推荐性能。为此,作者提出了一个新的框架等级用户意图网络(HUIGN)以层次图结构展示从细粒度到粗粒度的用户意图。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢