视觉Transformer已成为计算机视觉任务的重要模型之一。虽然它们优于之前的卷积神经网络,但其复杂度是与输入特征长度N呈二次关系。

为了解决这个问题,在本文中,作者提出了UFO-ViT(Unit Force Operated Vision Trnasformer) ,通过消除非线性来减少自注意力操作的计算量。通过只修改Self-Attention的几行代码,UFO-ViT能够实现线性的复杂度而不降低性能。在图像分类和密集预测任务上,本文提出的UFO-ViT高于大多数基于Transformer的模型。

论文标题:UFO-ViT: High Performance Linear Vision Transformer without Softmax

论文链接:https://arxiv.org/abs/2109.14382

复现链接:https://github.com/xmu-xiaoma666/External-Attention-pytorch#30-UFO-Attention-Usage

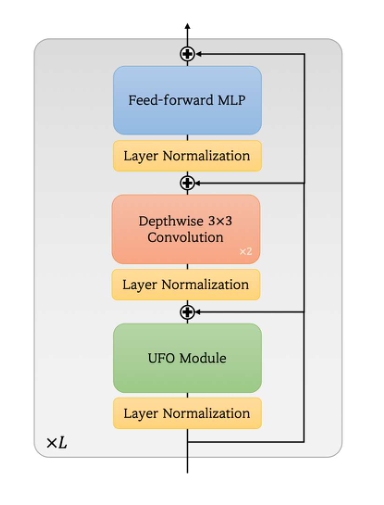

本文模型的结构如上图所示。它是一个卷积层,UFO模块和MLP层的混合结构。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢