-

为什么我们需要 Prompt 工具包? -

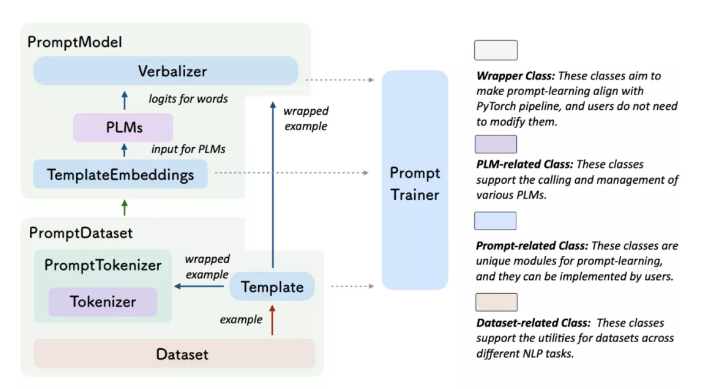

OpenPrompt 是什么?

-

OpenPrompt 的优势:为什么我们需要 OpenPrompt?

-

Next Step towards PromptCenter:不仅仅是 OpenPrompt

-

Prompt learning 的性能并不是很稳定,需要考虑诸多的因素,诸如 template 和 verbalizer 的设计,tunable token 和 label words 的初始化和预训练模型的选择等。 -

一些 Prompt 的工作仍基于传统 fine-tuning 的代码模版,用最小的更改成本来实现 Prompt learning,代码耦合程度较高,缺乏可读性和可复现性。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢