Transformer不仅在自然语言表达方面表现出色,在计算机视觉方面的潜力也被挖掘出来,不断称霸各大CV榜单。

Transformer的成功主要归功于注意力层的表示学习能力,这种能力也能够支持Transformer模型在其他领域上的应用。

最近,有研究人员将生成对抗网络(GAN)中常用的CNN主干网络替换为Transformer用于图像合成。一些前期研究结果表明,将Transformer直接用于GAN中并不是一件很容易的事,特别是之前被设计用于分类的GAN中经常会导致CNN图像合成性能的下降。

例如与基于CNN的StyleGAN2实现的3.16 FID相比,ViT作为主干网络的GAN模型仅在64×64 Celeba数据集中实现了8.92的FID。Frechet Inception Distance (FID) 计算结果为真实图像计算的特征向量与生成的图像之间的距离。

此外,这种Transformer结构也会使GAN网络的训练变得更加不稳定,严重依赖于手工调整超参数。

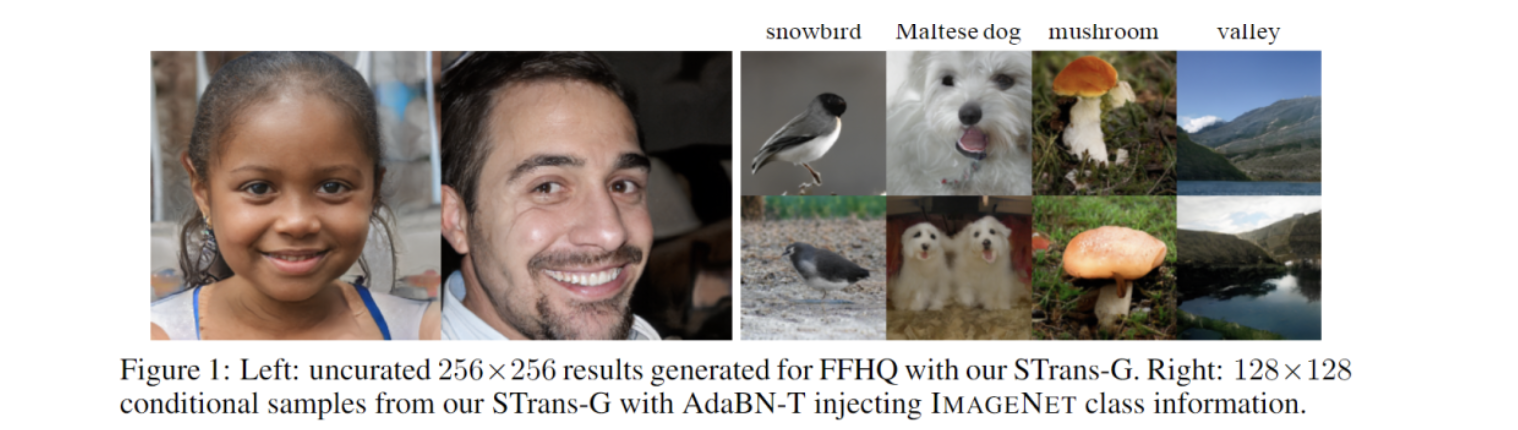

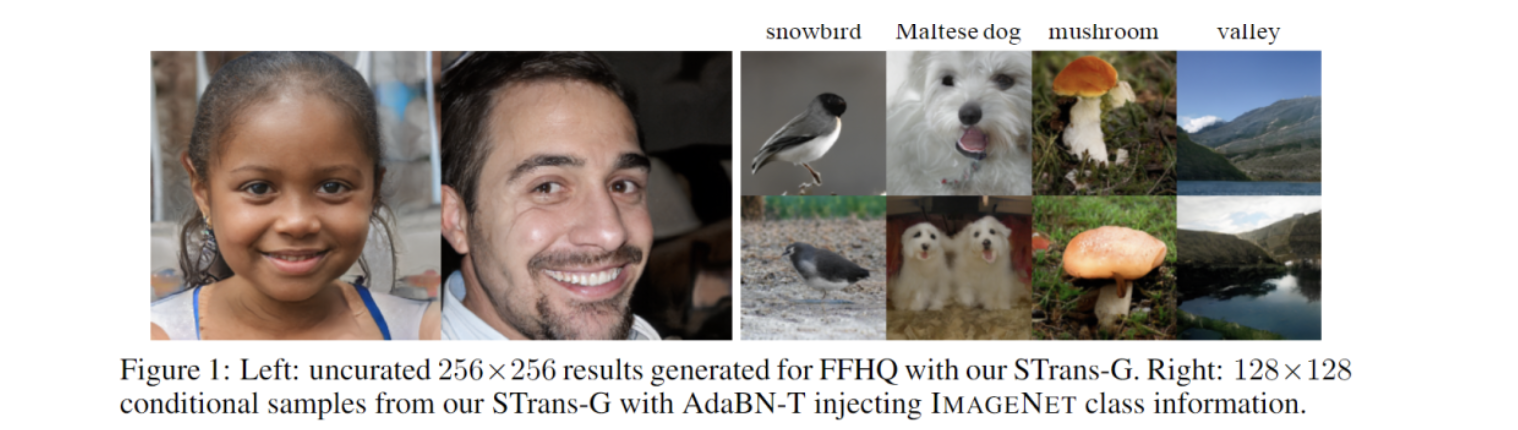

针对这个问题,来自香港中文大学的研究人员发表了一篇论文,旨在了解GAN 模型中Transformer 的内在行为,以缩小基于Transformer的GAN模型与基于CNN主干的GAN模型之间的性能差距。文中不仅研究了无条件的图像合成,而且还研究了如何更少地探索的条件设置。

这项研究也是首次在条件设计(conditional setting)下成功使用基于Transformer的GAN模型。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢