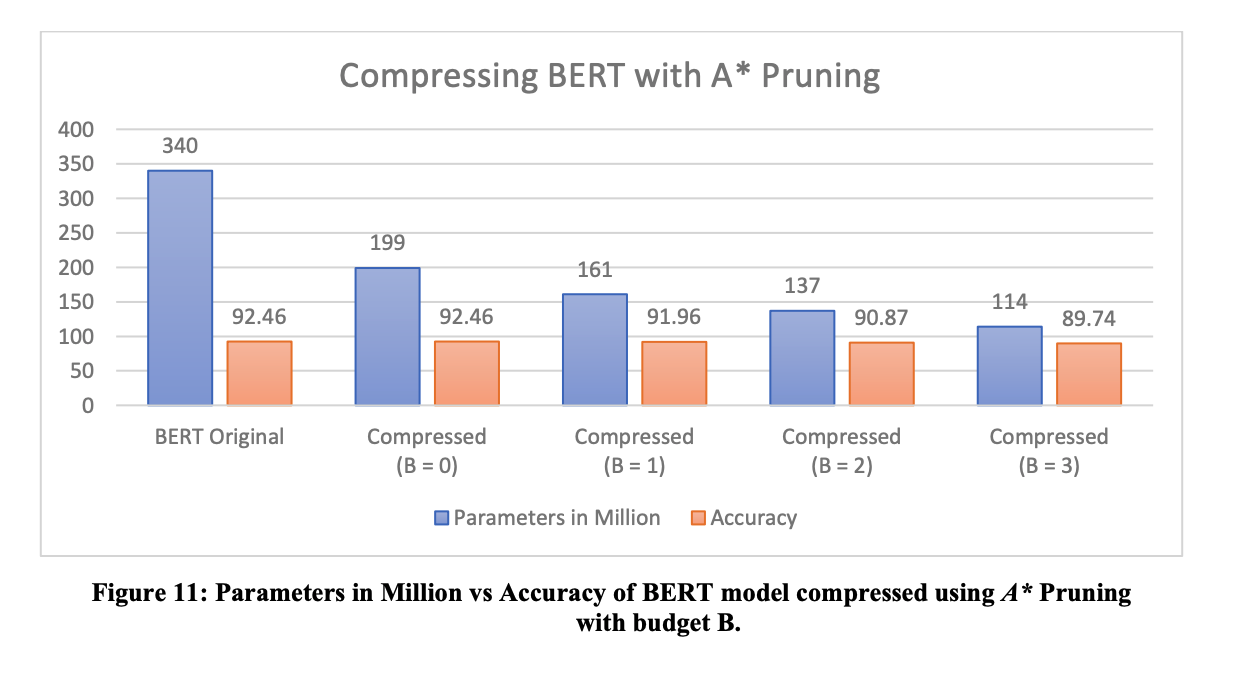

近年来,在NLP甚至CV中越来越多地采用 Transformer 模型。然而,由于规模大小的原因,此类模型在资源受限的计算环境中采用率有限。本文提出了新颖的剪枝算法,通过消除冗余的Attention Heads来压缩 Transformer 模型。研究人员使用 A* 搜索算法来获得具有最小精度保证的剪枝模型。结果表明,该方法可以消除 BERT transformer模型中多达 40% 的注意力头,而几乎没有精度损失。论文:https://arxiv.org/pdf/2110.15225.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢