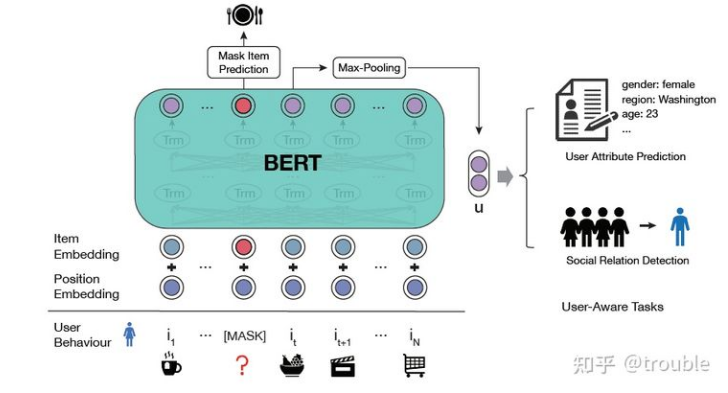

一、UPRec: User-Aware Pre-training for Recommender Systems [submitted to TKDE]

先前的推荐系统里的预训练模型都只是专注于利用用户行为序列里面的通用序列模式,但是他们忽视了使用用户的信息来捕获个性化的兴趣。在这篇文章里作者提出一个用异构用户信息来增强预训练模型,叫做 User-aware Pre-training for Recommendation (UPRec). UPRec利用用户属性和结构化的社交图来构建预训练阶段的自监督目标函数并提出两个用户感知的预训练任务。

与NLP领域的预训练的区别:NLP里面的预训练专注于学习通用的语言知识,而推荐系统不仅应该利用通用的序列模式,而且应该捕获每个用户的个性化的兴趣。因此在预训练的时候利用用户信息还是很有必要的。

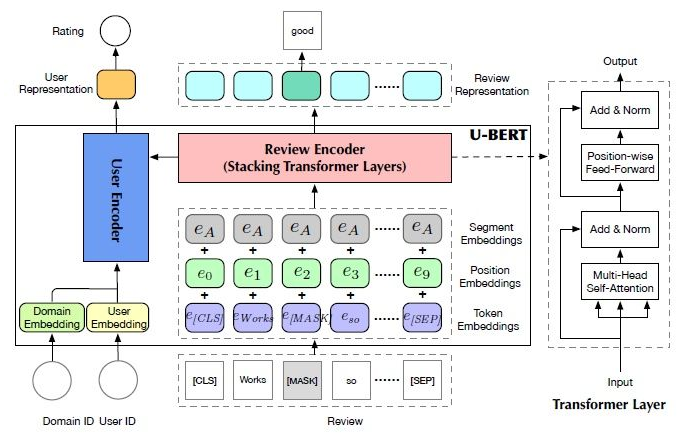

二、U-BERT: Pre-training User Representations for Improved Recommendation [AAAI 21]

用户表示通常是从行为数据(点击、评论内容)里面学习。但是,对于不那么流行的域,行为数据不足以让模型充分地学习到精确的用户表示。为了解决这个问题,一个自然的想法就是用内容丰富的域来补全用户表示。受最近NLP领域的Bert的启发,我们提出了一个新颖的预训练和微调为基础的方法U-BERT。不同于BERT,U-BERT是专门为推荐系统定制的。在预训练阶段,U-BERT专注于内容丰富的域并引进一个用户编码器和评论编码器来建模用户的行为。两个预训练策略也被提出来学习通用的用户表示;在微调阶段,U-BERT专注于目标内容不丰富的域,出了预训练阶段的两个编码器,U-BERT进一步引入了物品编码器来建模物品表示。此外,一个review co-matching layer也被提出去从用户和物品的评论里面学习语义更丰富的交互。最终,U-BERT结合用户表示,物品表示和评论交互信息去提高推荐系统性能。

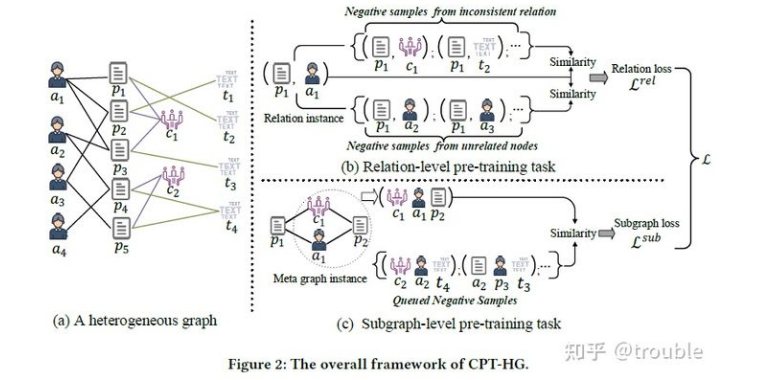

三、Contrastive Pre-Training of GNNs on Heterogeneous Graphs [CIKM 21]

尽管GNN已经是学习图表示的sota方法,但是他们通常都需要大量的标签数据来使得模型能够训练出满意的性能,而标签数据通常是昂贵且难以获得的。为了缓解标签稀疏的问题,一些预训练的任务策略开始被应用于GNNs上,来从图的通用结构属性上学习可迁移的知识。但是,现有的预训练策略都只是为同质图设计的,而本文认为,异构图能够表示更丰富的语义,这是被现有工作所忽视的。在这篇文章中,我们提出一个新颖的异构图上基于GNN的对比预训练策略(CPT-HG)来用自监督的方式捕获语义和结构信息。特别地,我们在关系级和子图级都设置了对应的语义感知的预训练任务并进一步用对比学习增强他们的表示。

四、Pre-Training Graph Neural Networks for Cold-Start Users and Items Representation [WSDM 21]

尽管最近GNN上的工作吸收高阶协同信号来缓解冷启动问题,但是冷启动用户和物品的embedding还是没有显示优化,并且在GNN的图卷积里没有考虑冷启动节点的冷启动邻居。这篇文章提出去在推荐之前预训练一个GNN模型。不同于推荐的目标,这个预训练的GNN通过有充分交互的用户、物品里面模拟冷启动的场景并且将重建embedding作为pretext task,因为这样的话就可以直接优化embedding的质量然后能够简单地应用到新的冷启动的用户和物品上。为了进一步减少冷启动的邻居的影响,我们考虑了一个自注意力为基础的元聚集器去增强每一步图卷积的聚集能力,并且考虑了一个自适应的邻居采样来根据预训练的模型的反馈选择邻居。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢