超图(Hypergraph)是一种广义上的图,它的一条边可以连接任意数量的顶点。关于超图的研究一直以来也收到了图神经网络领域的关注,主要的研究领域是推荐系统。

今天分析文章的最近关于超图的一些研究。

Hypergraph相关研究

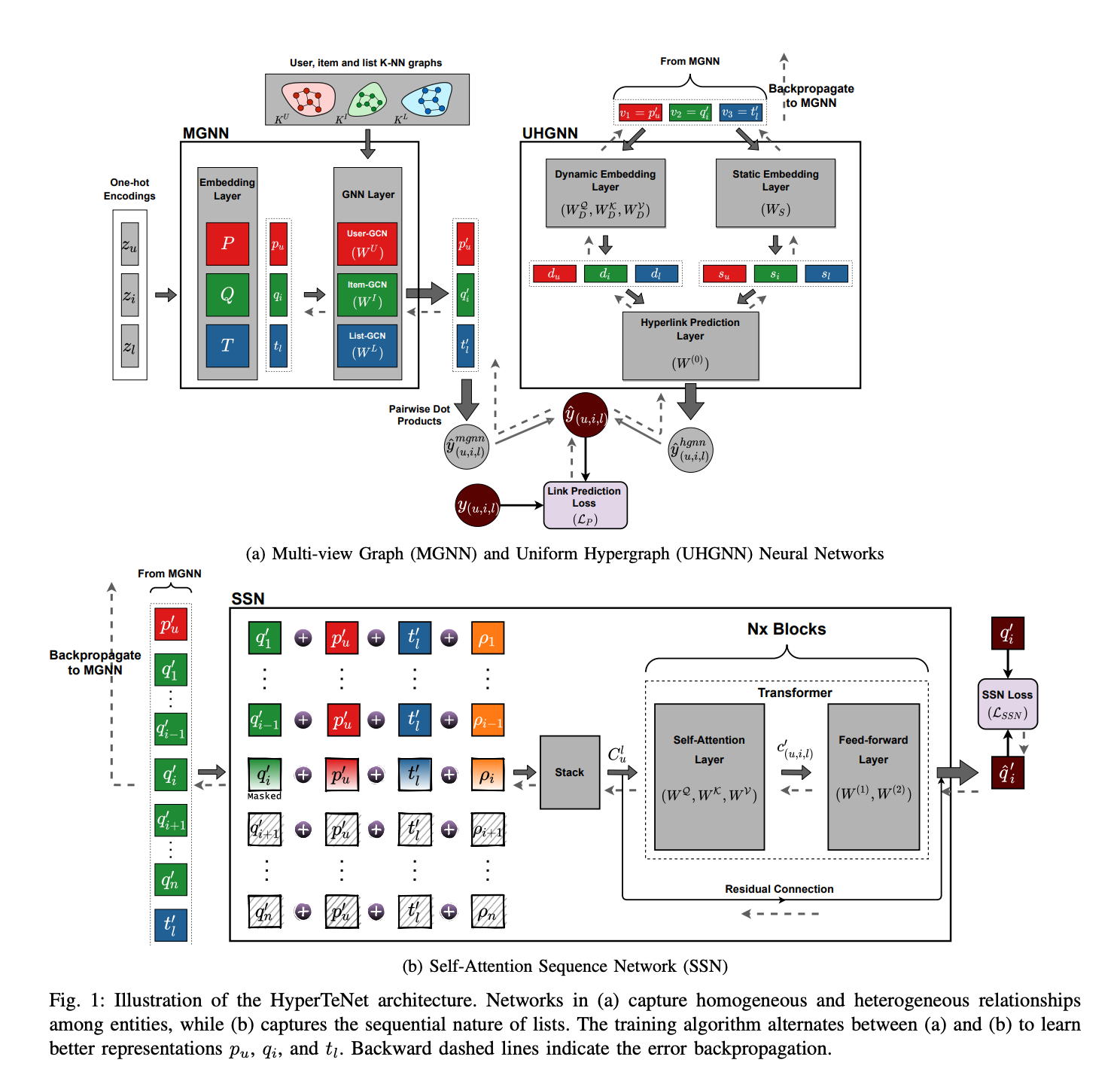

1.【ICDM2021】HyperTeNet: Hypergraph and Transformer-based Neural Network for Personalized List Continuation

地址: https://arxiv.org/abs/2110.01467

代码:https://github.com/mvijaikumar/HyperTeNet

个性化列表延续任务 (PLC)是以个性化的方式将下一个项目加入到用户生成列表中。

该任务的主要挑战是如何利用现有工作未考虑的交互实体(用户、项目和列表)之间的三元关系。此外,过去的工作没有考虑相同类型实体之间的多跳关系,和在列表中已经存在的项目中的顺序信息。

在本文中,作者提出了 HyperTeNet——一种用于个性化列表延续任务的自注意力超图和基于 Transformer 的神经网络架构,以解决上述挑战。

文章使用图卷积来学习相同类型实体之间的多跳关系,并利用基于自注意的超图神经网络来学习交互实体之间的三元关系。

此外,实体嵌入与基于 Transformer 的架构共享,并通过交替优化过程来进行学习。实验结果表明,HyperTeNet 在现实世界的数据集上明显优于其他最先进的模型。

2. 【CIKM2021】Double-Scale Self-Supervised Hypergraph Learning for Group Recommendation

地址:https://arxiv.org/abs/2109.04200

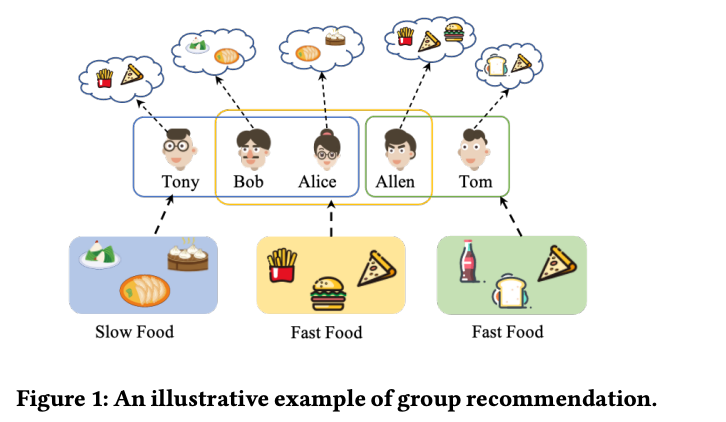

导读:随着社交媒体的流行,研究者尝试将推荐系统的建模从个体转向群体推荐。由于群体偏好是群体成员各种偏好的混合,群体推荐的基本挑战是建模成员之间的相关性。现有方法大多采用

启发式或基于注意力的偏好聚合策略综合群体偏好。然而,这些模型主要关注用户的成对连接,而忽略了复杂的群体内外的高阶互动。此外,由于严重稀疏的组-项目交互,推荐系统受到数据稀疏问题的严重影响。在本文中,作者提出了一个自我监督的超图学习框架来实现群推荐的两个目标:(1)捕捉用户之间的群内和群间交互; (2)缓和数据原始数据本身的稀疏性问题。对于(1),作者开发了一个基于用户和组级超图的分层超图卷积网络来模拟复杂的组内和组外用户之间的元组相关性。为了(2),作者设计了一个双尺度节点 dropout 策略来创建自我监督信号,可以用针对稀疏问题的不同粒度。在多个基准数据集的分析实验证明了所提出模型的优越性,也阐明了超图建模和双尺度自监督的价值

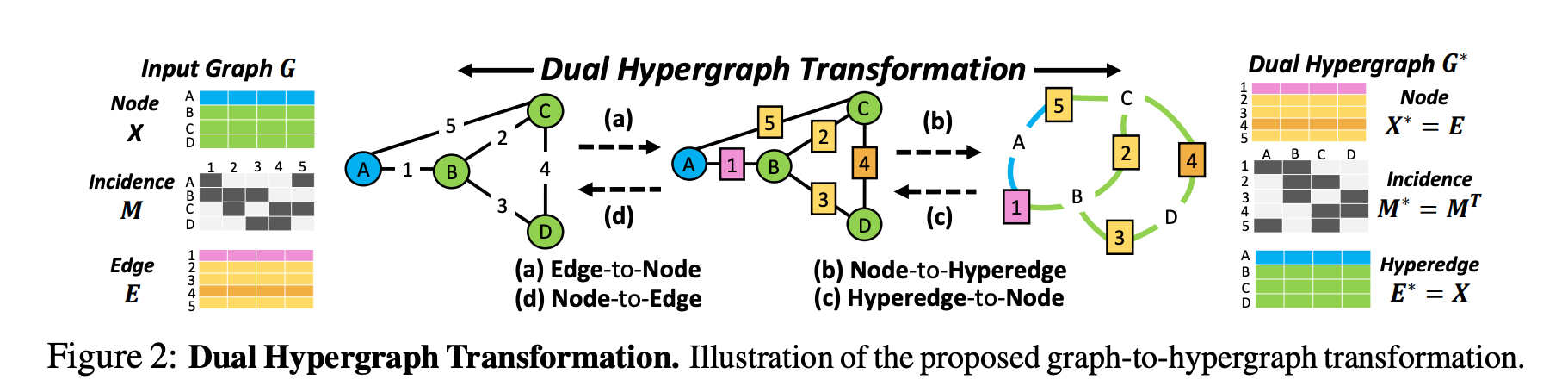

3. 【NeurIPS 2021】Edge Representation Learning with Hypergraphs

地址:https://papers.nips.cc/paper/2021/file/3def184ad8f4755ff269862ea77393dd-Paper.pdf

导读:已有的图神经网络主要专注于从节点捕获信息考虑到它们的连通性,并没有太多的工作来学习边的表示。边是图的基本组成部分。准确地学习给定图的边的表示对于图表示学习的至关重要。

为此,本文提出了一种新的基于边表示的学习框架对偶超图变换 (DHT),将其变换一个图到超图的节点。这种双超图结构将节点表示的消息传递技术应用于边的表示。进而从超图中获取边的表示,然后聚类或删除

边以获得整体图级的边表示。文章验证了提出模型在不同图数据集上的超图表示学习方法,在很大程度上优于现有的图表示学习方法。此外,文章所题模型的在图分类方面也大大优于最先进的图池化方法,不仅因为其准确的边表示学习,也是由于其对节点的无损压缩并去除不相关的边以实现有效的消息传递的原因。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢