摘要

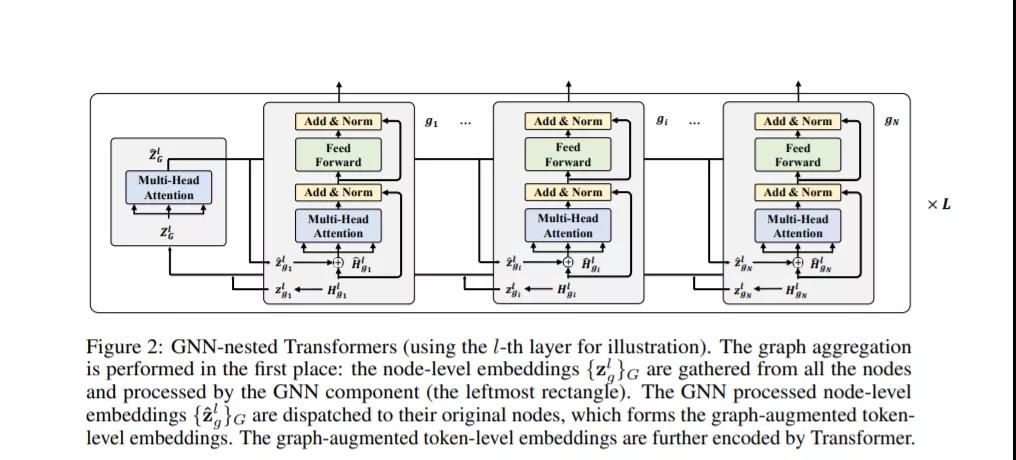

文本图的表示学习是基于单个文本特征和邻域信息为节点生成低维嵌入。现有的工作主要依赖于级联模型结构:首先通过语言模型对节点的文本特征进行独立编码;然后通过图神经网络对文本嵌入进行聚合。然而这种文本特征独立建模的结构限制了模型的效果。故本文提出了 GraphFormers ——将 GNN 组件嵌套在 Transformer 语言模型的一种新架构。在该架构中,文本编码和图聚合融合为一个迭代工作流,使得每个节点的语义都能从全局角度准确理解。此外,还引入了一种渐进式学习策略,该策略在操作数据和原始数据上连续训练模型,以增强其在图形上整合信息的能力。实验证明,本文提出的架构在 3 个数据集上都取得了最好结果。

论文链接:https://arxiv.org/abs/2105.02605

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢