【标题】Reinforcement Learning based Path Exploration for Sequential Explainable Recommendation

【作者团队】Yicong Li, Hongxu Chen, Yile Li, Lin Li, Philip S. Yu, Guandong Xu

【发表日期】2021.11.24

【论文链接】https://arxiv.org/pdf/2111.12262v1.pdf

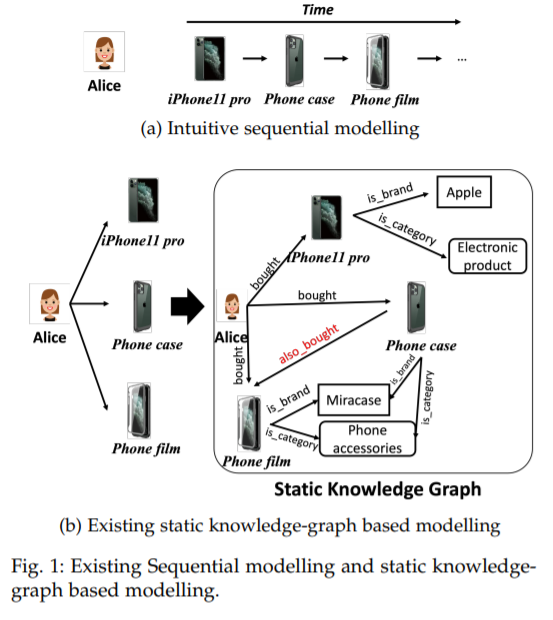

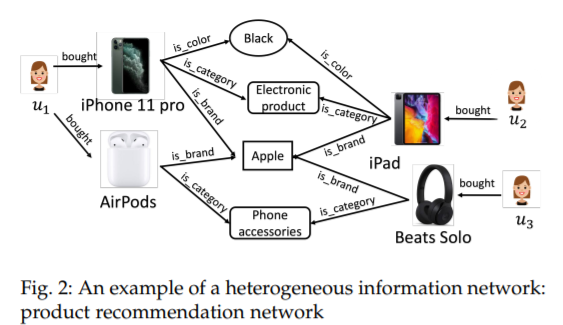

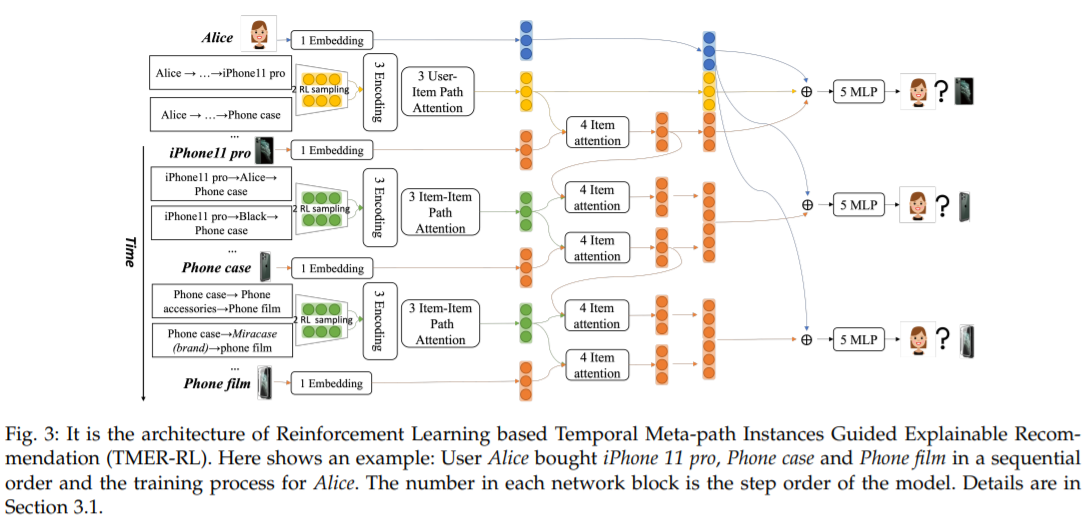

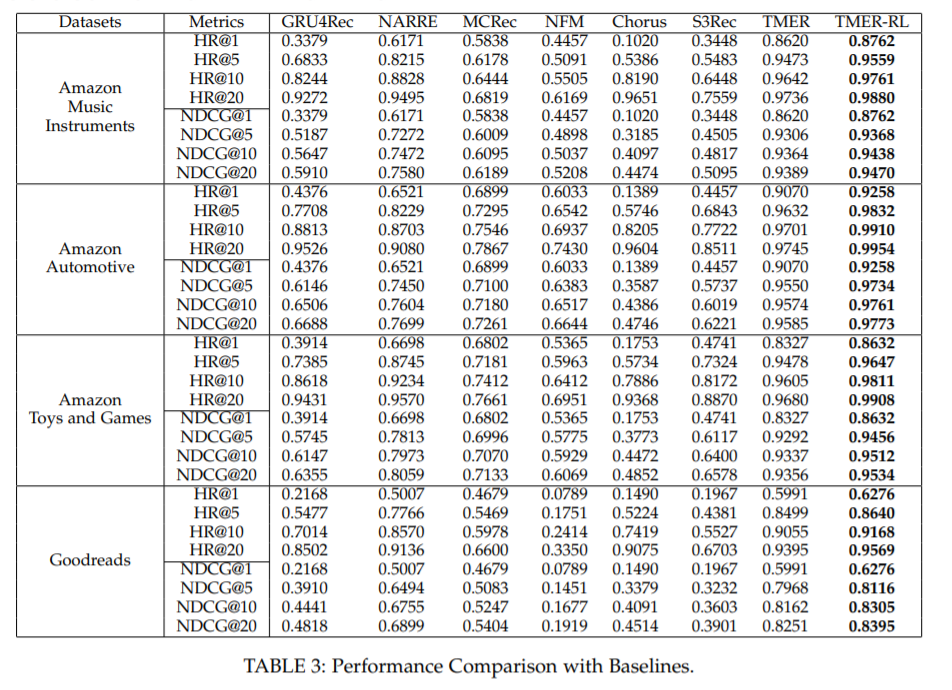

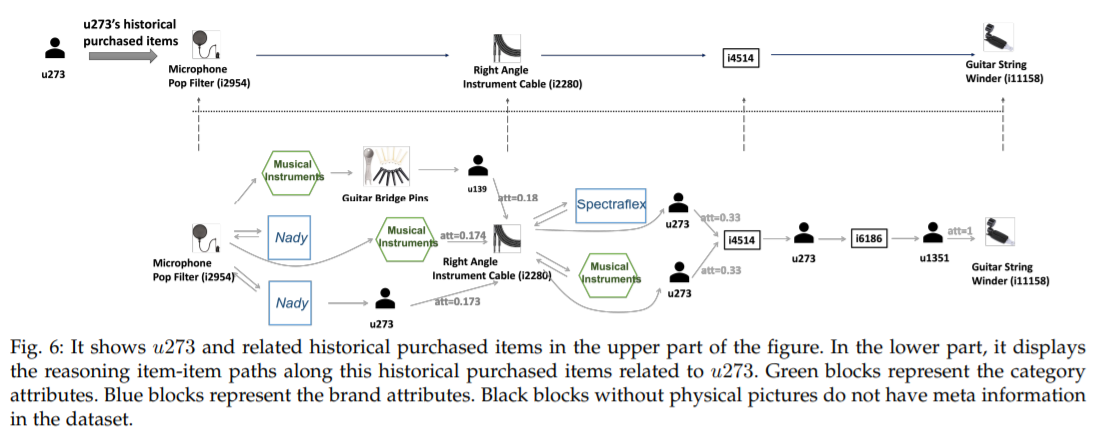

【推荐理由】由于知识图提供了丰富的信息,基于路径的可解释推荐系统的最新研究进展引起了越来越多的关注。大多数现有的可解释的推荐只利用静态的图谱,而忽略了动态的用户-物品演变,导致解释不太有说服力和不准确。尽管有一些工作意识到对用户的时间顺序行为建模可以提高推荐系统的性能和可解释性,但其中大多数要么只专注于对路径内用户的顺序交互进行建模,要么独立于推荐机制。本文提出了一种新颖的利用强化学习的时态元路径引导的可解释推荐(TMER-RL),其利用具有注意机制的连续项目之间的强化项目路径建模,在动态知识图上对动态用户项目演化进行顺序建模,以实现可解释推荐。与使用重循环神经网络对时间信息进行建模的现有工作相比,本文提出了简单但有效的神经网络来捕获用户的历史物品特征和基于路径的上下文来表征下一个购买的物品。在两个真实数据集上对TMER进行的广泛评估显示,与最近的强基线相比,TMER具有最先进的性能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢