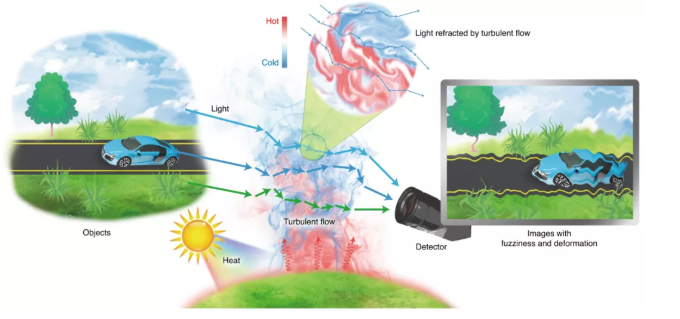

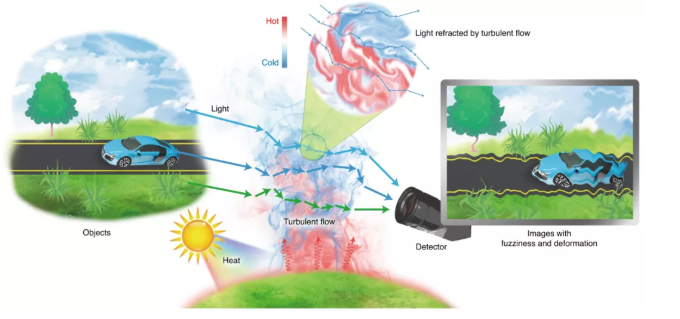

影像拍摄已经渗透到了现代人生活的方方面面。然而无论是手持摄像还是街边监控都会受到环境中各方面因素的影响,从而导致拍摄图像不清晰,大气湍流便是这众多因素之一。

具有不同尺度涡流的湍流介质在波传播过程中会引起折射率的波动,干扰原有的空间关系、相位关系和光路。二维成像系统的输出受到这种效应带来的变形的影响。随机性以及多种类型的退化使得分析相互的物理过程成为一项具有挑战性的任务。

来自北京航空航天大学的研究团队,提出了一个生成对抗网络(TSR-WGAN);它集成了嵌入在三维输入中的时间和空间信息,以学习观察到的和潜在的理想数据之间残差的表示。无需额外假设湍流的规模和强度即可生成视觉友好且可信的序列。

研究人员利用数据集对 TSR-WGAN 进行了测试。该数据集包含 27,458 个序列,411,870 帧算法模拟数据、物理模拟数据和真实数据。TSR-WGAN 展示了较高的视觉质量和对随机扰动和对象运动之间差异的深刻理解。这些初步结果还揭示了深度学习从特定角度解析随机物理过程以及在有限数据的情况下解决复杂图像重建问题的潜力。

该研究以「Neutralizing the impact of atmospheric turbulence on complex scene imaging via deep learning」为题,于 2021 年 10 月 14 日发布在《Nature Machine Intelligence》。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢