本文分享北邮石川教授团队被AAAI'21接收的一篇论文:「Learning to Pre-train Graph Neural Networks」。

单位:北邮 & 腾讯等

论文链接:

https://yuanfulu.github.io/publication/AAAI-L2PGNN.pdf

代码链接:

https://github.com/rootlu/L2P-GNN

传统的GNN预训练模型遵循一个两步骤的模式:

-

用大量无标签数据进行模型预训练,得到图编码过程中的通用知识;

-

用下游特定任务中有标签数据对模型进性微调,以使通用知识适应于下游任务。

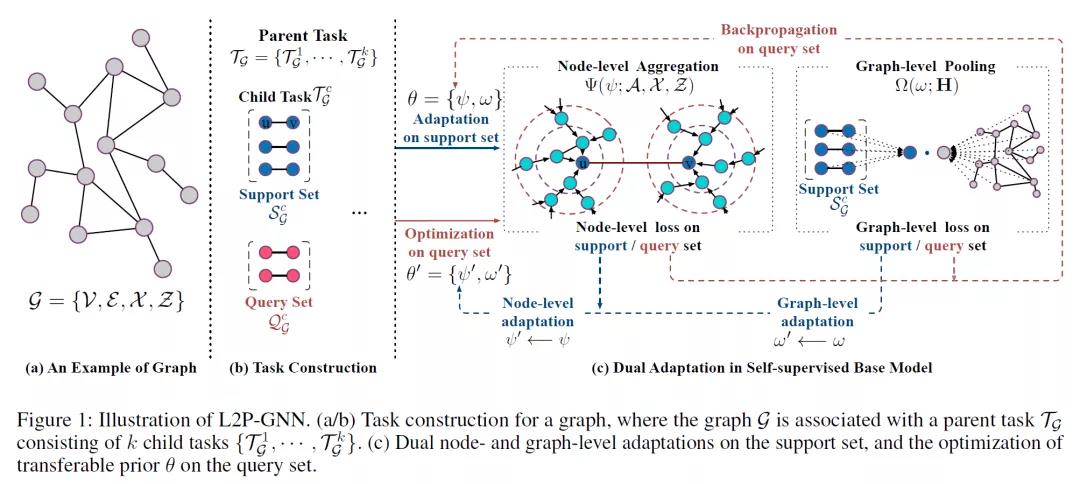

这两个步骤的优化目标不一致,使其之间存在较大的差距。本文分析了预训练和微调之间的这种差距,并提出一种自监督的GNN预训练模型(L2P-GNN)来缓解两步骤优化目标不一致带来的问题。其主要思想是尝试在预训练的过程中用先验知识进行微调。 实验结果表明,L2P-GNN 能够学习有效的、可转移的先验知识,从而为下游任务提供强有力的表示。

贡献:

-

第一个探索在预训练过程中缓解预训练和微调目标之间的分歧的模型,为预训练的学习提供一个新的视角

-

针对节点和图级的表示,提出一种完全自监督的GNN预训练策略

-

建立一个新的大规模数据集,用于预训练的数据集。并在两个不同领域的数据集上1进行实验,表明该方法达到最优性能。

L2P-GNN的核心思想是学习预训练GNN,以弥补预训练和微调过程之间的分歧。任务定义为在图上从局部和全局的角度捕获结构和属性。预训练学到的先验知识可以快速适应一个新的任务。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢