作者:Xumin Yu, Lulu Tang, Yongming Rao, 等

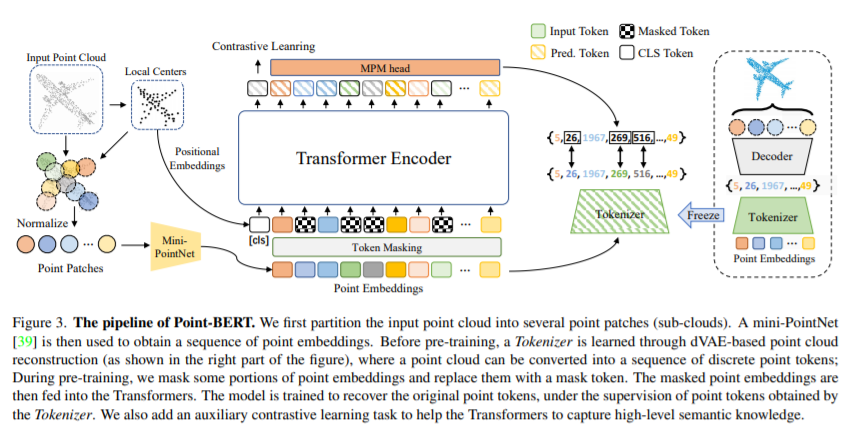

简介:作者提出了Point-BERT:一种将BERT的概念推广应用到三维点云的新学习范式。受BERT的启发,作者设计了一个遮盖点建模任务来预训练点云Transformer。具体而言,作者首先将点云进行分割,得到若干局部点云,并通过一个离散变分自动编码器(dVAE)进行局部点云的离散编码。通过该步骤,点云被表示为若干个离散编码。然后,作者随机屏蔽一些输入点云,并将它们输入主干Transformer。预训练的目标是预测屏蔽位置的局部点云离散编码。大量实验表明,所提出的BERT风格的预训练策略显著提高了标准点云Transformer的性能。通过本文的预训练策略,实验证明标准Transformer在ModelNet40上达到93.8%的准确率,在ScanObjectNN的最难设置上达到83.1%的准确率,用更少的手工设计和人为先验超过了精心设计的点云模型。作者还证明,Point-BERT学习到的特征表示可以很好地转移到新的任务和领域,模型提高了小样本点云分类任务的最新水平。代码和预训练模型已开源发布到:https://github.com/lulutang0608/Point-BERT 。

论文下载:https://arxiv.org/pdf/2111.14819.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢