作者:Zihan Liu, Feijun Jiang, Yuxiang Hu,等

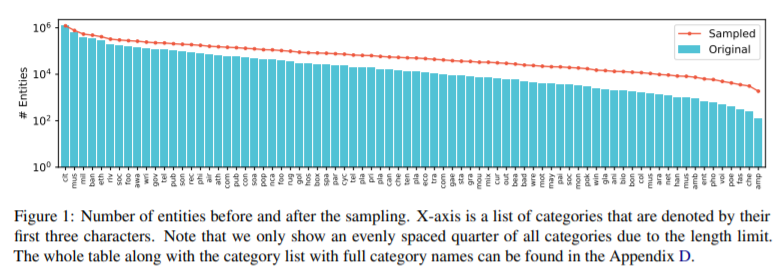

简介:本文研究利用预训练语言模型解决数据稀疏的命名实体识别问题。当大型训练数据集不可用于低资源域时,命名实体识别 (NER) 模型通常表现不佳。最近,大规模语言模型的预训练成为应对数据稀缺问题的一个有前途的方向。然而,语言建模和 NER 任务之间的潜在差异可能会限制模型的性能,并且很少研究 NER 任务的预训练,因为收集的 NER 数据集通常或大或小但质量低下。在本文中,作者构建了一个质量相对较高的海量 NER 语料库,并基于创建的数据集预训练了 NER-BERT 模型。实验结果表明,作者的预训练模型在九个不同领域的低资源场景中可以显着优于 BERT 以及其他强基线。此外,实体表示的可视化进一步表明了NER-BERT对各种实体进行分类的有效性。

论文下载:https://arxiv.org/pdf/2112.00405.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢