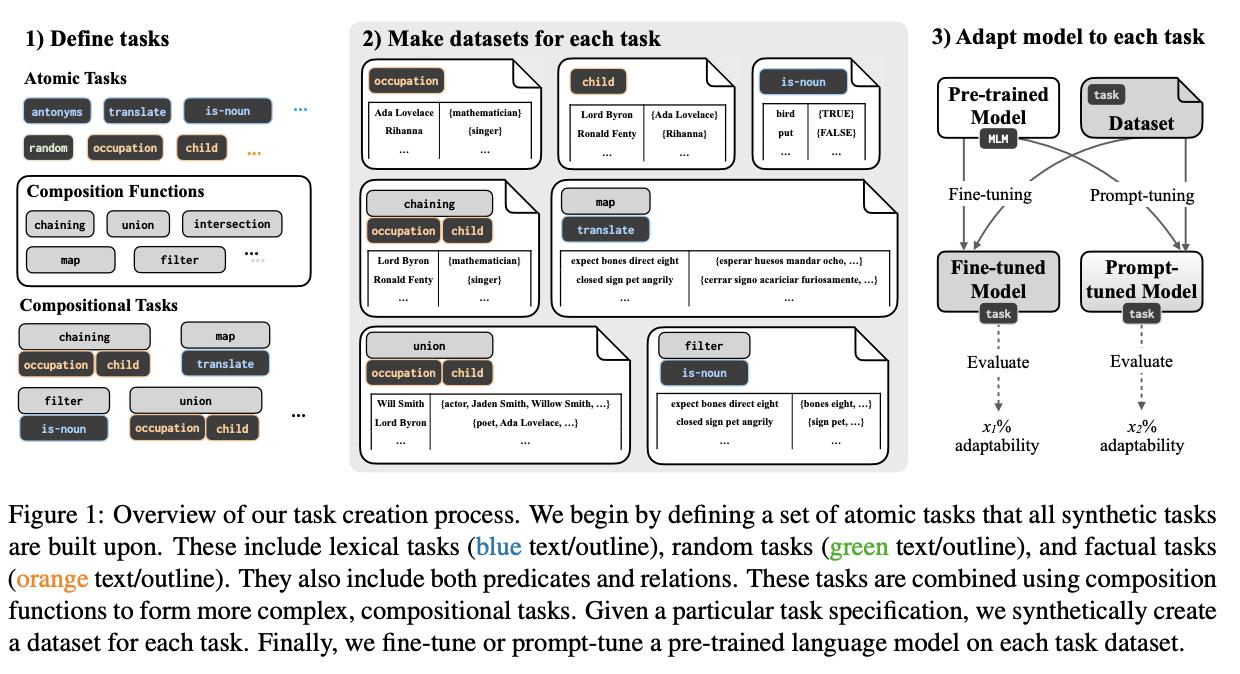

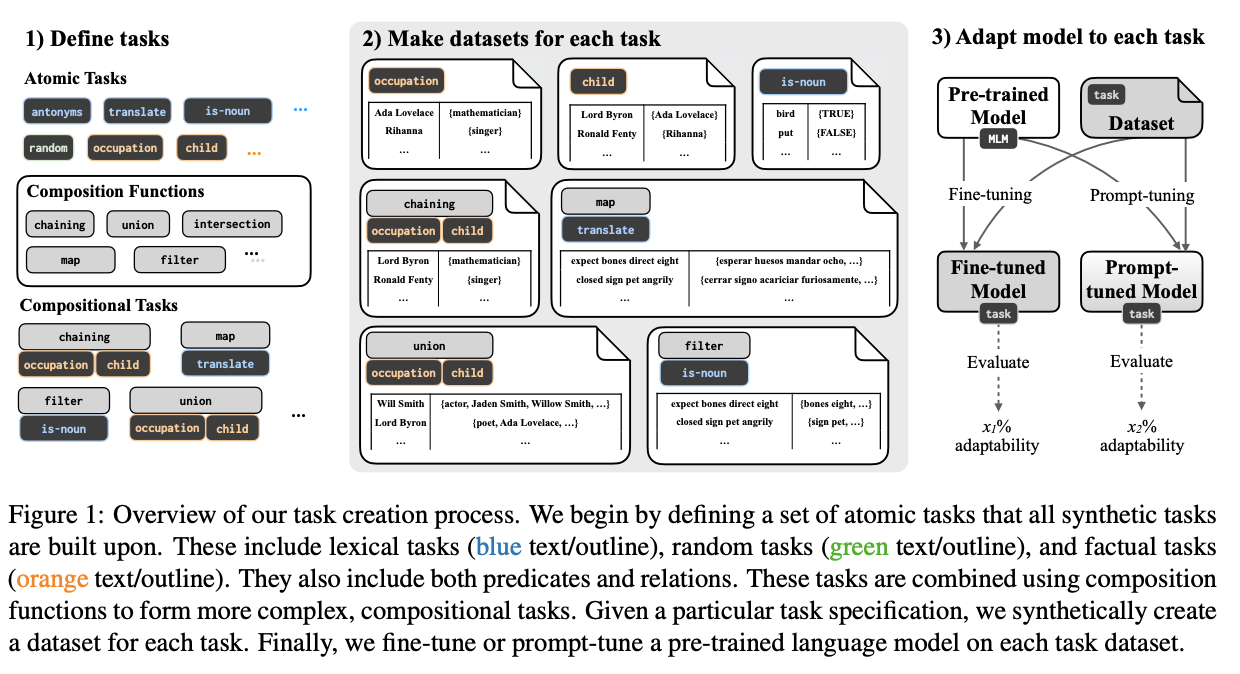

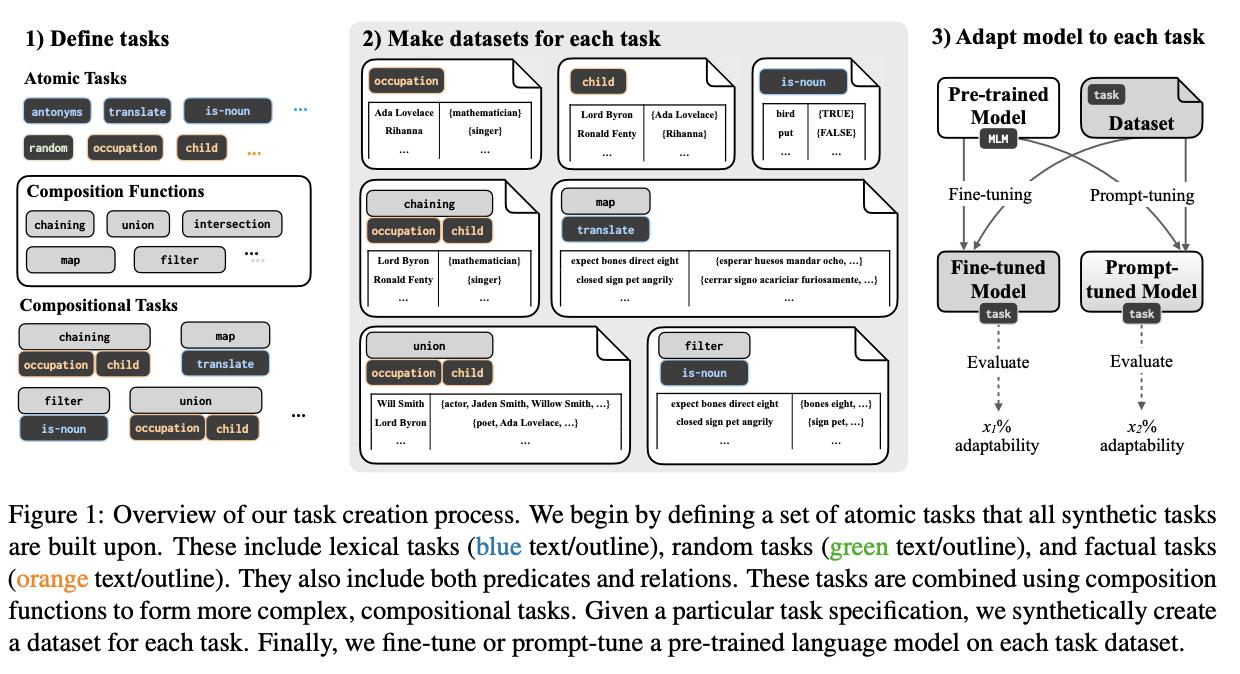

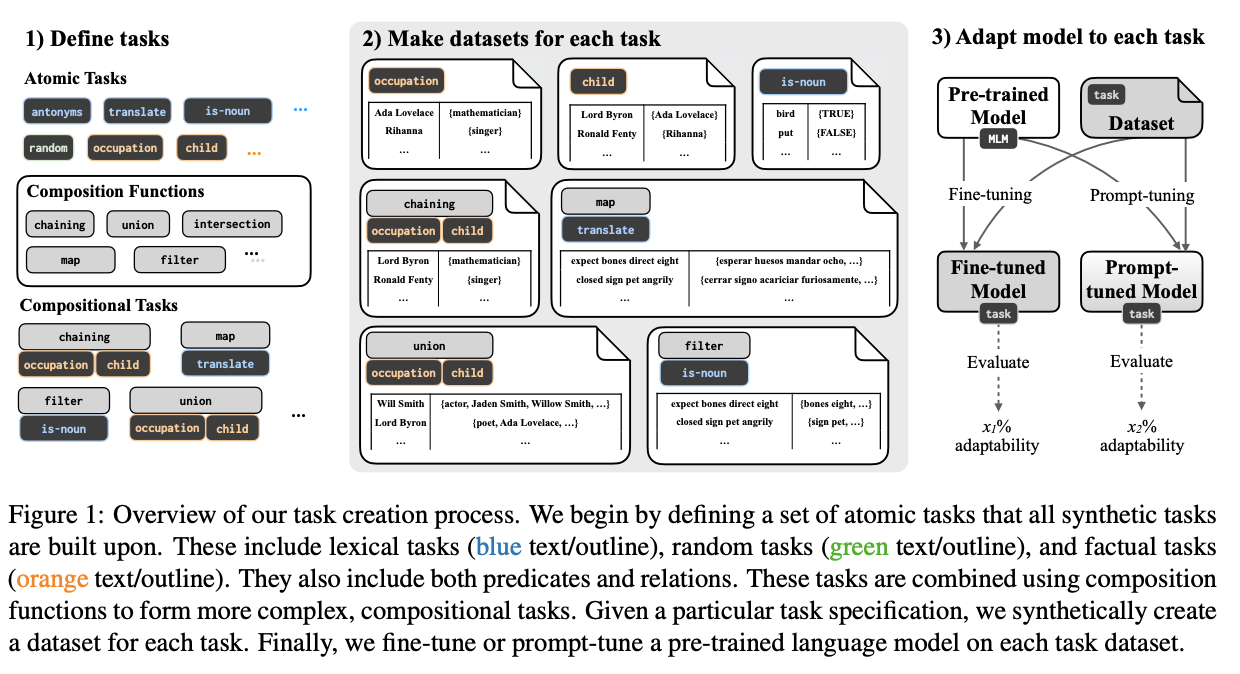

标题:MIT、Meta AI|Quantifying Adaptability in Pre-trained Language Models with 500 Tasks(量化具有500个任务的预训练语言模型的适应性)

https://github.com/belindal/TaskBench500

https://arxiv.org/pdf/2112.03204v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

https://github.com/belindal/TaskBench500

https://arxiv.org/pdf/2112.03204v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢