目前提出的图神经网络 (GNN) 方法没有考虑训练图和测试图之间的不可知偏差,从而导致 GNN 在分布外(OOD)图上的泛化性能变差。导致 GNN 方法泛化性能下降的根本原因是这些方法都是基于 IID 假设。在此条件下,GNN 模型倾向于利用图数据中的虚假相关进行预测。但是,这样的虚假相关可能在未知的测试环境中改变,从而导致 GNN 的性能下降。因此,消除虚假相关的影响对于实现稳定的 GNN 模型至关重要。

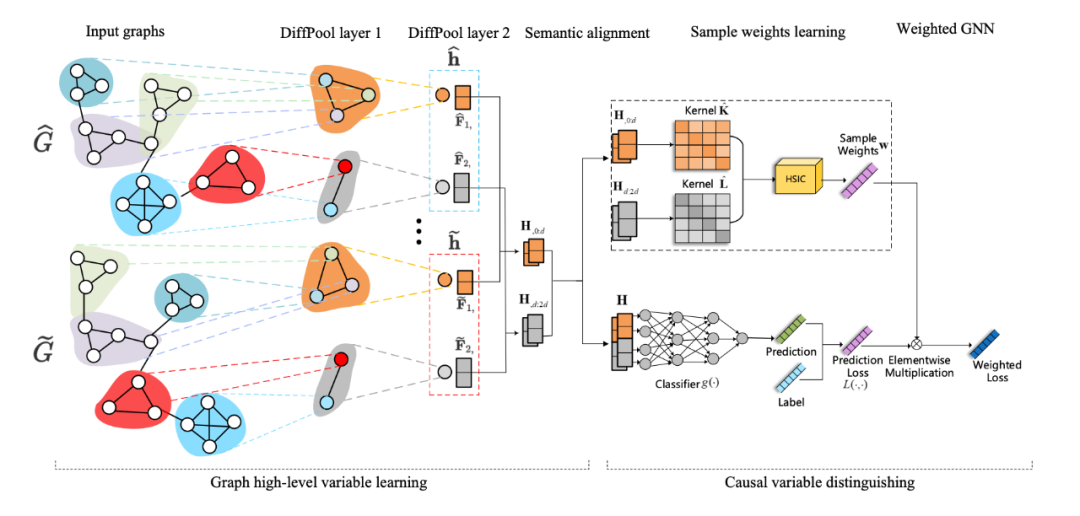

为了实现此目的,在本文中,我们强调对于图级别任务虚假相关存在于子图级别单元,并且用因果视角来分析 GNN 模型性能下降的原因。基于因果视角的分析,我们提出了一个统一的因果表示框架用于稳定 GNN 模型,称之为 StableGNN。这个框架的主要思想是首先利用一个可微分的图池化层提取图的高层语义特征,然后借助因果分析的区分能力来帮助模型摆脱虚假相关的影响。因此,GNN 模型可以更加专注于有区分性的子结构和标签之间的真实相关性。我们在具有不同偏差程度的仿真数据和 8 个真实的 OOD 图数据上验证了我们方法的有效性。此外,可解释性实验也验证了 StableGNN 可以利用因果结构做预测。

论文标题:

Generalizing Graph Neural Networks on Out-Of-Distribution Graphs

论文链接:

https://arxiv.org/abs/2111.10657

所提出框架的基本想法是设计一个因果表示学习方法来抽取有意义的图高层语义变量然后估计他们对于图级别任务的真实因果效应。如下图 2所示,所提出的模型框架主要分为两个部分:图高层语义表示学习模块和因果变量区分模块。

StableGNN的模型框架

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢