作者:Ananya Karthik, Mike Wu, Noah Goodman, Alex Tamkin

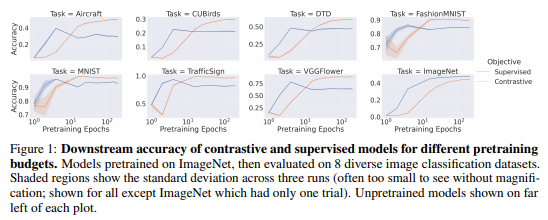

简介:本文研究预训练监督学习与对比学习的高低优劣。对比学习在计算机视觉方面取得了长足进步,在一系列下游数据集上的表现优于监督预训练。然而,对比学习是否在所有情况下都是更好的选择?作者展示了两种情况。首先,在足够小的预训练预算下,ImageNet 上的监督预训练在八个不同的图像分类数据集上始终优于可比的对比模型。这表明,在数百或数千个时期比较预训练方法的常见做法可能无法为那些计算预算更有限的人提供可操作的见解。其次,即使有更大的预训练预算,作者也确定了监督学习占优势的任务,也许是因为监督预训练的以对象为中心的偏差使模型对常见的损坏和虚假的前景-背景相关性更具弹性。这些结果强调需要在更广泛的背景和训练制度中表征不同预训练目标的权衡。

注:本文已被NeurIPS 2021 研讨会收录。

论文下载:https://arxiv.org/pdf/2112.05340.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢