标题:谷歌|SELF-ATTENTION DOES NOT NEED O(n^2) MEMORY(自注意力不需要O(n^2)内存)

作者:Markus N. Rabe, Charles Staats

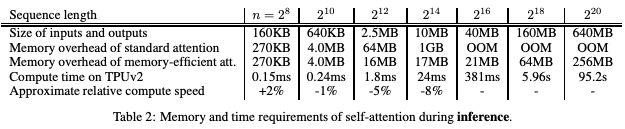

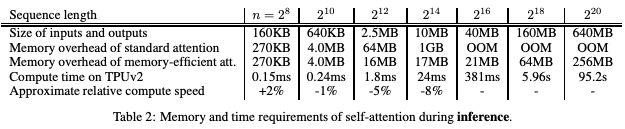

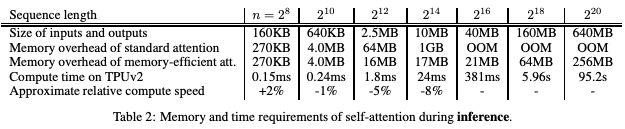

简介:本文提出一个精简的自注意力算法。作者提出了一个非常简单的注意力算法,对于序列需要O(1)内存长度和需要 O(logn) 内存的自注意力的扩展。 这与经常陈述的观念,即自注意力需要 O(n^2)内存。 虽然时间复杂度是还是O(n^2),加速器设备内存而不是计算能力通常是现代技术的限制因素。 因此,减少注意力的记忆需求,允许处理更长的时间序列可能是可行的。 作者为加速器提供了实际的实现需要 O(√n) 内存,在数值上是稳定的,并且在标准注意力执行运行时间的百分之几以内。作者还演示了如何对函数求导,并维持存储效率。对于序列长度16384,自注意力的内存开销在推理时减少了59倍,求导时减少了32倍。

论文下载:https://arxiv.org/pdf/2112.05682v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢