作者:Timothy Nguyen, Zhourong Chen, Jaehoon Lee

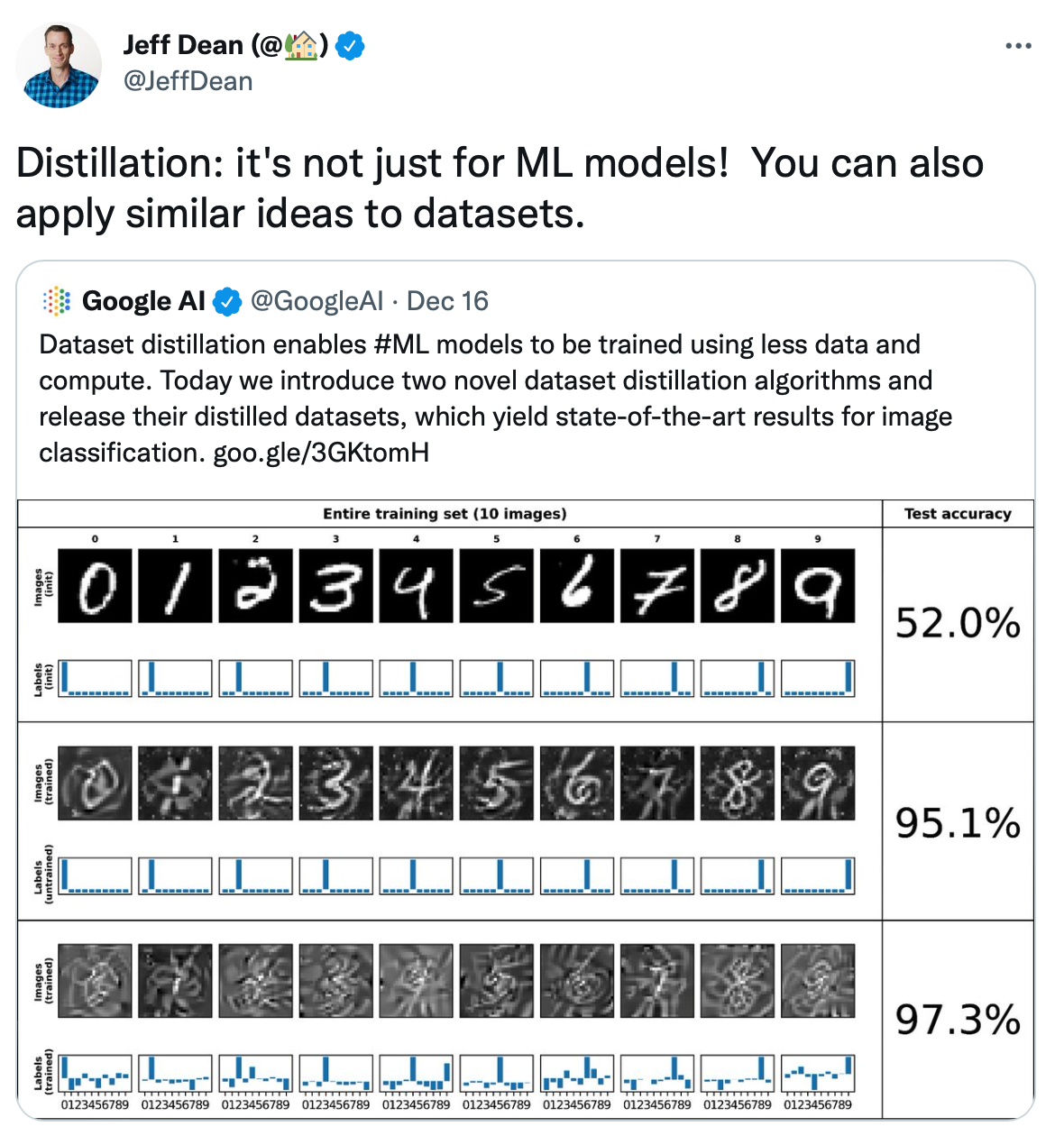

简介:本文研究通过对数据集蒸馏提炼实现训练机器学习模型效能的提升。为提升机器学习算法的效能,通常必须从大量训练数据中提取有用的特征;但在大型数据集上不菲的训练成本可能导致此过程具有非常的挑战性。对此,业界通常使用模型蒸馏(或称为:知识蒸馏) 的方法:将大型复杂教师模型预训练提炼成较小的模型。在本文,作者重点研究另一种选择:“数据集蒸馏”的新方法,即将大型数据集提炼成一个合成的、较小的数据集,使用经蒸馏提炼的数据集训练模型将可以减少所需的内存和计算。在本研究中,作者基于“深度神经网络的无限宽度极限理论”,通过两种新的数据集蒸馏算法:核心诱导点(KIP)与标签求解(LS),实现了数据集的蒸馏提炼,并在基准图像分类数据集上实现了最先进的性能。特别是在CIFAR-10分类任务上:尽管有限宽度的ConvNet神经网络(1)仅使用10张图像:就实现了50%的测试精度;(2)使用500张图像实现了68%的测试精度;但最终仍然获得了最先进的结果。

相关链接: Google博客文章| 源码|论文

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢