代码:https://github.com/Christian-lyc/NAM

论文:https://arxiv.org/abs/2111.12419

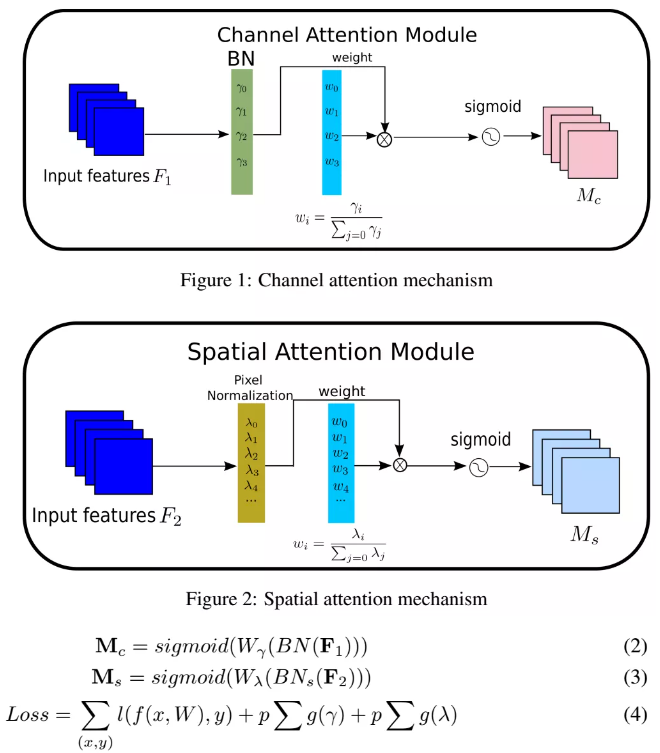

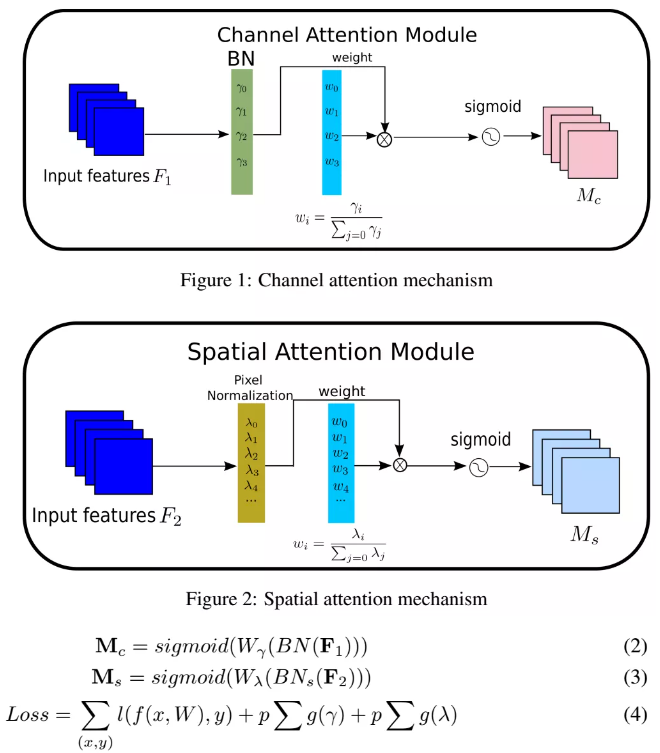

本文介绍了一种新的计算注意力的方式,相比于之前的注意力机制,无需额外的全连接,卷积等额外的计算和参数,直接使用BN中的缩放因此来计算注意力权重,并通过增加正则化项来进一步抑制不显著的特征。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

代码:https://github.com/Christian-lyc/NAM

论文:https://arxiv.org/abs/2111.12419

本文介绍了一种新的计算注意力的方式,相比于之前的注意力机制,无需额外的全连接,卷积等额外的计算和参数,直接使用BN中的缩放因此来计算注意力权重,并通过增加正则化项来进一步抑制不显著的特征。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

沙发等你来抢

评论

沙发等你来抢