作者:Siddhant Arora,Danish Pruthi,Norman Sadeh,等

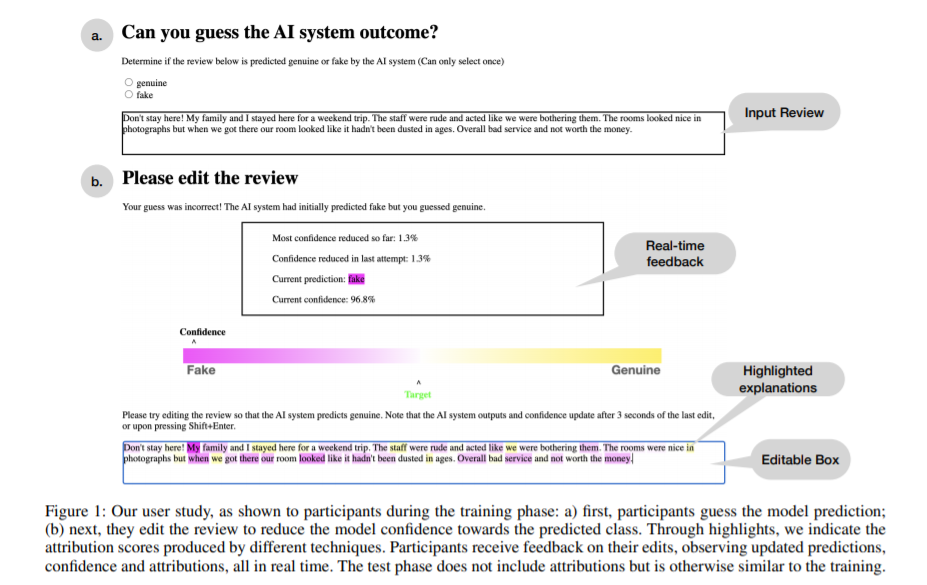

简介:本文为解释机器学习模型的预测,研究人员提出了数百种将预测归因于重要特征的技术。虽然这些归因常常被认为有可能提高人类对模型的“理解”,但令人惊讶的是,很少有工作明确评估实现这一愿望的进展。在本文中,作者进行了一项众包研究:参与者与欺骗检测模型互动,该模型经过训练、能够区分真假酒店评论。当前面临的挑战是在新评论上模拟模型以及编辑评论、以降低最初预测的类的概率(成功的操纵,将导致一个截然相反的案例)。在训练阶段而非测试阶段,输入范围会突出显示、以能传达显著性。通过作者的评估:实验观察到与无解释控制相比、对于线性词袋模型、在训练期间能够访问特征系数的参与者能够在测试阶段导致模型置信度的更大降低。对于基于BERT的分类器,流行的局部解释并不能提高其在无解释情况下降低模型可信度的能力。值得注意的是,当通过一个线性模型的(全局)属性来解释BERT模型时,人们可以有效地操纵该模型。

论文下载:https://arxiv.org/abs/2112.09669

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢