2021年即将结束,但AI的突破不停。OpenAI几个小时前刚刚在arxiv上发布图像合成方面的最新研究成果 GLIDE: Towards Photorealistic Image Generation and Editing with Text-Guided Diffusion Models ,效果惊人。

论文摘要

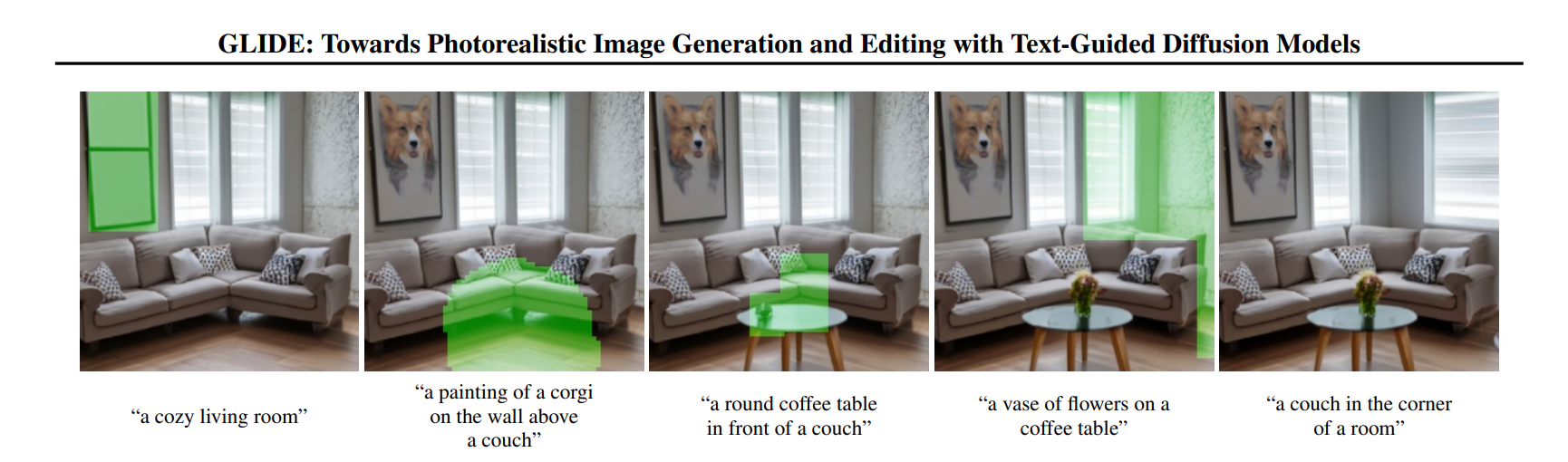

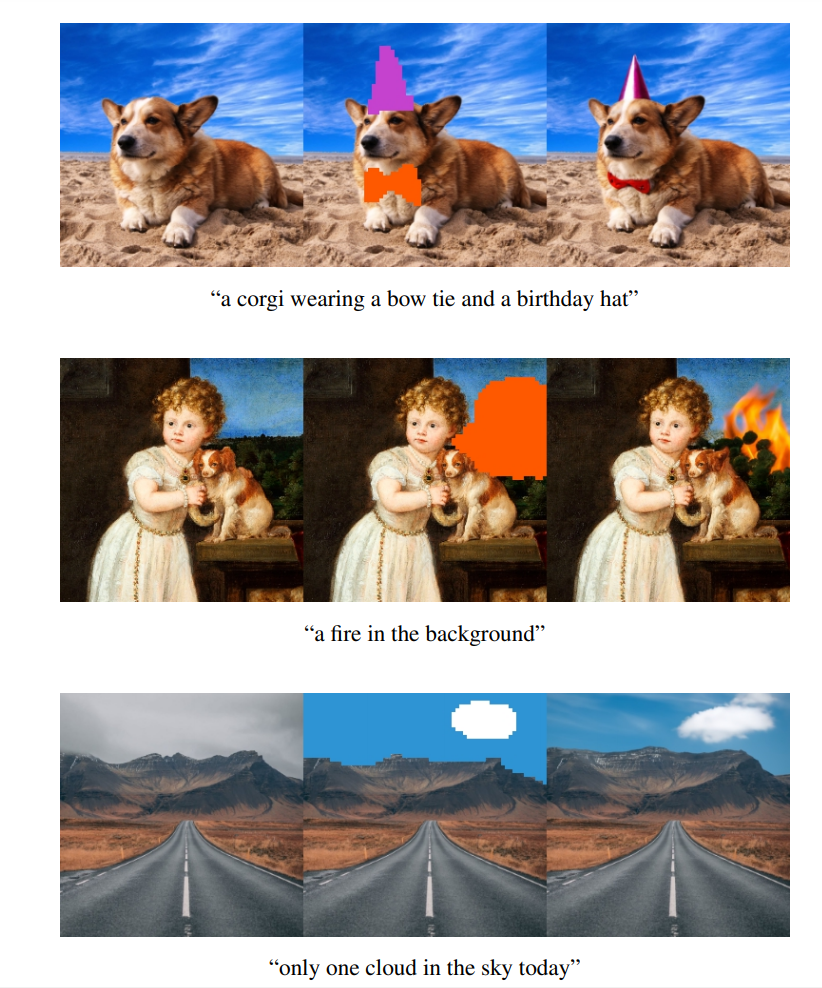

扩散模型最近已被证明可以生成高质量的合成图像,尤其是与引导技术结合使用,可以用多样性换保真性。我们探索了文本条件图像合成问题的扩散模型,并比较了两种不同的指导策略:CLIP指导和无分类器指导。我们发现后者在照片写实度和标题相似性方面更受评估人员的青睐,并且通常会产生照片级逼真的样本。使用无分类指导的 35 亿参数文本条件扩散模型产生的样本比DALL-E的更受评估人员的青睐,即使后者使用昂贵的 CLIP 重新排序。此外,我们的模型还可以微调进行图像修复,从而实现强大的文本驱动的图像编辑。我们在过滤后的数据集上训练了一个较小的模型,代码和权重都已经在GitHub上发布。

论文中生成的一些图片效果:

项目的GitHub页面里也介绍了局限:

尽管在训练前应用了数据集过滤,但GLIDE (filtered) 仍然显示出超出人类图像的偏见。例如:

当被要求为男孩和女孩生成玩具时,它会产生不同的输出。

当被要求生成“一个宗教场所”时,它倾向于生成教堂的图像,而这种偏见被无分类的指导放大了。

它可能更倾向于生成仇恨符号,而不是万字符和联盟旗。我们的仇恨符号过滤器专门针对这两个案例,因为在我们的数据集中,我们发现很少有仇恨符号的相关图像。然而,我们也发现,该模型在更广泛的符号集上的能力有所下降。

对于复杂的提示,或者包含在训练数据中没有很好表示的概念的提示,GLIDE (filtered) 可能无法产生现实的输出。虽然模型的数据被过滤掉了某些类型的图像,但数据仍然显示出对以西方为中心的概念的偏见。

并明确表示不推荐商用。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢