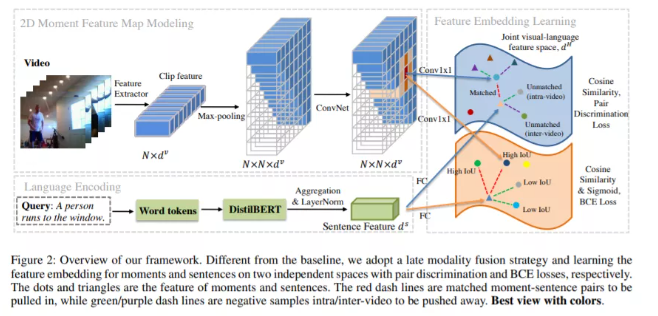

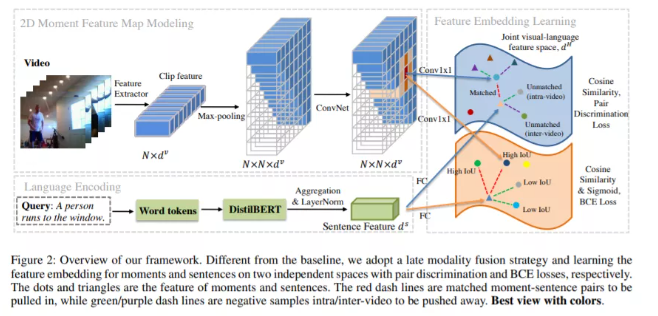

本方法(Mutual Matching Network, MMN)主要是从两个角度对现有方法进行改进:

第一个角度是使用跨模态对比学习增加文本和视频特征的可辨别性(more discriminative)从而提高最终的定位效果,具体做法是增加了一个使得两个模态双向匹配(mutual matching)的损失函数从而构造了许多新的监督信号。我们首次使用了此前方法忽视的文本负样本,并且首次揭示了跨视频负样本的重要性。我们对于负样本的探究对应了标题中的negative sample matters。

第二个角度是从度量学习的角度使用了一个多模态联合建模空间(joint visual-language embedding space)替换复杂的多模态融合模块,从而大幅降低了计算开销,并且使得前面提到的双向匹配loss成为可能。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢