标题:百度、鹏城实验室|ERNIE 3.0 Titan: Exploring Larger-scale Knowledge Enhanced Pre-training for Language Understanding and Generation(ERNIE 3.0 Titan:探索更大规模的知识增强型语言理解和生成预训练)

作者:Shuohuan Wang, Yu Sun, Yang Xiang, Haifeng Wang

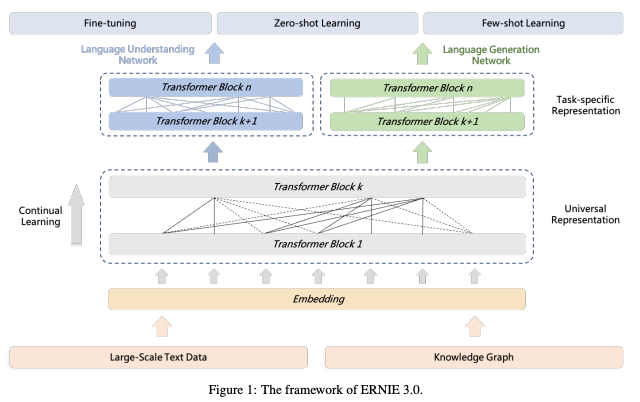

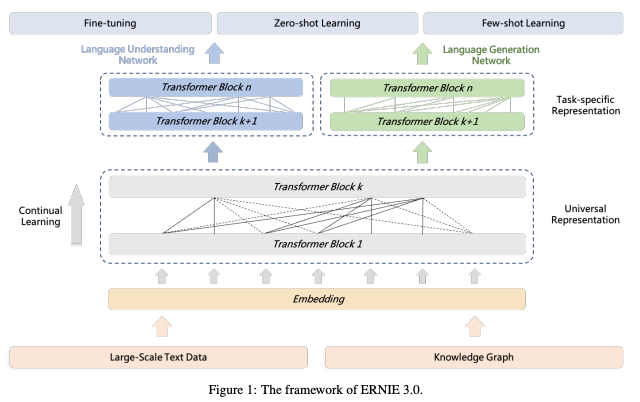

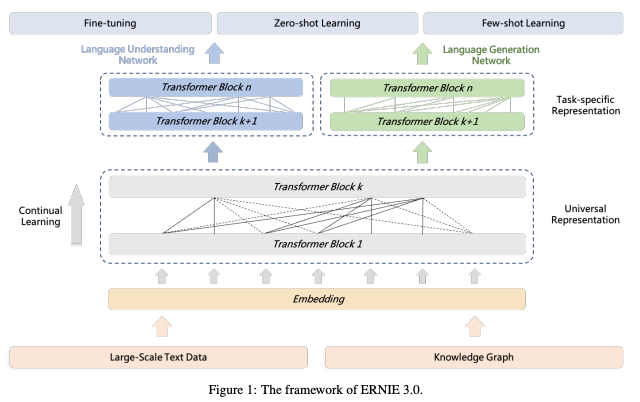

简介:本文介绍了一个中文大语言模型。作者提出了名为ERNIE 3.0的统一框架,用于预训练大规模知识增强模型,并训练了一个具有 100 亿个参数的模型。 ERNIE 3.0 在各种 NLP 任务上的表现优于最先进的模型。为了探索扩展 ERNIE 3.0 的性能,作者在PaddlePaddle平台上训练了具有多达2600亿个参数的百亿参数模型 ERNIE 3.0 Titan。此外,作者设计了一个自监督的对抗损失和一个可控的语言建模损失,使ERNIE 3.0 Titan 生成可信且可控的文本。为了减少计算开销和碳排放,作者为 ERNIE 3.0 Titan 提出了一个在线蒸馏框架,其中教师模型将同时教授学生和自我训练。ERNIE 3.0 Titan是迄今为止最大的中文密集预训练模型。实证结果表明,ERNIE 3.0 Titan在 68 个NLP数据集上的表现优于最先进的模型。

论文下载:https://arxiv.org/pdf/2112.12731v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢