【论文标题】Fine-Tuning Large Neural Language Models for Biomedical Natural Language Processing

【作者团队】Robert Tinn, Hao Cheng, Yu Gu, Naoto Usuyama, Xiaodong Liu, Tristan Naumann, Jianfeng Gao, Hoifung Poon

【发表时间】2021/12/15

【机 构】微软

【论文链接】https://arxiv.org/abs/2112.07869v1

生物医学研究人员和临床医生面临的一个长期挑战是如何跟上快速增长的出版物和医疗笔记。自然语言处理(NLP)已经成为驯服信息过载的一个有希望的方向。特别是,大型神经语言模型通过对无标签文本的预训练来促进迁移学习,BERT模型在各种NLP应用中的成功就是一个例子。然而,为最终任务微调这种模型仍然具有挑战性,特别是在小的标记数据集上。本文提出了一项关于生物医学NLP应用的大型神经语言模型微调的综合研究。作者表明,微调的不稳定性在低资源的生物医学任务中普遍存在,并且在不同的预训练设置和更大模型中进一步加剧。在对优化调整和特定层适应技术的彻底评估中,作者确定了微调稳定的最佳做法,为生物医学NLP的BLURB基准建立了新的技术状态。具体来说,冻结较低的层对标准的BERT-base模型有帮助,而层间衰减对BERT-large和ELECTRA模型更有效。对于诸如BIOSSES这样的低资源文本相似性任务,重新初始化顶层是最佳策略。总的来说,特定领域的词汇和预训练有利于更稳健的模型进行微调。另外本文探讨了未来的方向,包括应用于其他生物医学任务,探索临床NLP中的微调稳定性,进一步研究实际使用案例中的模型修剪和压缩。

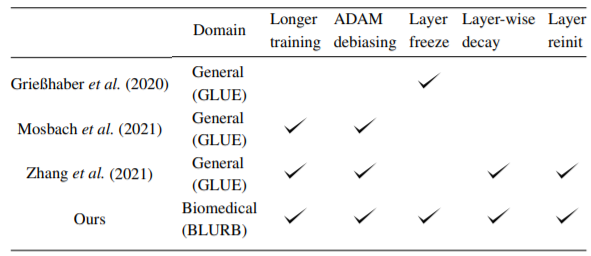

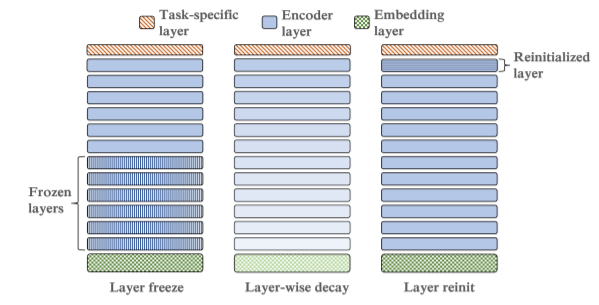

上图显示了本文的调查中对微调稳定技术的总结,其中主要包括层冻结,层衰减及层重置等操作,具体含义如下图所示。

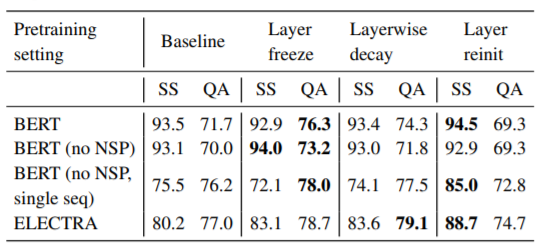

上图展示了句子相似性(SS)和问题回答(QA)任务的测试性能与主要的特定层适应方法的比较,图中都是用BASE模型。所有这三种方法都大体上是有益的,但它们的效果因任务和预训练设置而大不相同。冻结较低的层对具有标准MLM目标的BERT模型有帮助,而分层衰减对ELECTRA模型更有效。对于句子相似性,重新初始化顶层是最佳策略。作者将研究重点放在句子相似性和问题回答任务上,因为BLURB中的其他数据集相对较大,不会出现稳定性问题。作者探索了一种针对特定层的适应方法的组合,但在初步实验中发现收益不大

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢