人类有一种很神奇的能力,可以使用一种感官方式(比如触摸)来提供通常由另一种感官(比如视觉)收集的环境信息。这种适应性能力,被称为感官替代 (Sensory substitution),是神经科学领域一个很有名的现象。一些有难度的适应,例如适应上下颠倒着看东西、学习骑乘“反转”自行车,或学习通过解读放置在舌头上的电极网格发射的视觉信息来“看”,可能需要几周、几个月甚至几年的时间才能掌握,但无论多难,人们最终都能够适应感官替代。

-

上下颠倒

https://www.sciencedirect.com/science/article/abs/pii/S0010945217301314

-

“反转”自行车

https://ed.ted.com/best_of_web/bf2mRAfC

-

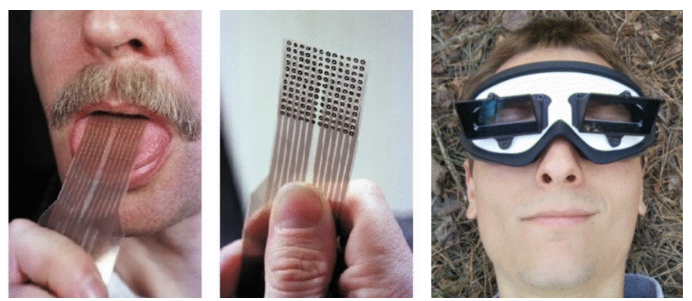

左图:舌显象装置(Maris 和 Bach-y-Rita,2001;图片:Kaczmarek,2011);右图:“倒置眼镜”,最初由 Erismann 和 Kohler 构思于 1931 年。(图片:维基百科 Upside down goggles)

-

舌显象装置

https://www.sciencedirect.com/science/article/abs/pii/S0006899301026671

-

Kaczmarek,2011

https://www.sciencedirect.com/science/article/pii/S1026309811001702#f000020

然而,大多数神经网络根本无法适应感官替代。例如,大多数强化学习 (Reinforcement Learning, RL) 代理要求其输入采用预先指定的格式,否则就会失败。对于这些代理来说,其输入需要为固定大小,且输入的每个元素都应该带有指定位置的像素强度等精确含义,或者带有位置或速度等状态信息。在主流 RL 基准任务(例如 Ant 或 Cart-pole)中,如果以当前 RL 算法训练的代理在感觉输入上发生变化,或者代理获得与当前任务无关的额外嘈杂输入,该代理将失败。

-

Ant

https://pybullet.org/

-

Cart-pole

https://github.com/google/brain-tokyo-workshop/tree/master/learntopredict/cartpole

-

RL 算法

hhttps://github.com/DLR-RM/stable-baselines3

在 NeurIPS 2021 的焦点论文“感觉神经元作为转换器:用于强化学习的置换不变神经网络 (The Sensory Neuron as a Transformer: Permutation-Invariant Neural Networks for Reinforcement Learning)”中,我们研究了置换不变 (permutation invariant) 神经网络代理,它要求每个感觉神经元(从环境中接收感觉输入的感受器)理解其输入信号的含义和背景,而不是明确假设一个固定的含义。实验表明,此类代理能够稳健地应对包含额外冗余或嘈杂信息的观察,以及损坏和不完整的观察。

-

焦点论文

https://arxiv.org/abs/2109.02869

-

感觉神经元作为转换器:用于强化学习的置换不变神经网络

我们在较简单的状态观察环境中证明了这种方法的稳健性和灵活性。代理接收的观察输入是低维向量,包含有关代理状态的信息,例如其组件的位置或速度。在流行的 Ant 移动任务中,代理共有 28 个输入,包含位置和速度等信息。我们在试验期间多次打乱输入向量的顺序,结果表明代理始终能够快速适应和继续前进。

在 cart-pole 中,代理的目标是摆动安装在推车中心的推车杆并使其保持直立。通常,代理只会看到 5 个输入,但我们修改了 cartpole 环境,提供了 15 个重排的输入信号,其中 10 个是纯噪声,其余是来自环境的实际观察。代理仍然能够执行任务,表明系统有能力处理大量输入并且只关注它认为有用的通道。这种灵活的能力适合处理来自定义不明确系统的未指定数量的大量信号,此类信号大部分都是噪声。

我们还将这种方法应用于高维视觉环境,其中的观察是像素图像流。这一部分研究的是屏幕重排版本的视觉强化学习环境。每个观察帧都被划分为一个图块网格,代理必须像拼拼图一样在重排的顺序下处理图块,确定待采取的行动方案。为演示视觉任务上的方法,我们创建了一个重排版本的 Atari Pong。

代理在这里的输入是一个可变长度的图块列表,因此只能从屏幕上“看到”图块的子集,与典型的强化学习代理不同。在拼图 Pong 实验中,我们将屏幕上的随机图块样本传递给代理,然后在游戏的其余部分进行修复。我们发现,丢弃 70% 的图块后(在这些固定随机位置),代理经过训练仍然能在对抗内置 Atari 对手时表现良好。有趣的是,如果我们随后向代理展现额外的信息(例如,允许它访问更多的图块),即使没有额外训练,其性能也会提高。代理按照重排的顺序收到所有图块后,每次都会获胜,这一结果与训练时看到整个屏幕的代理相同。

我们发现,在训练中使用无序观察施加额外的障碍也会带来额外的好处,例如,CarRacing 训练环境的背景换为新图像后,任务中未见的变化得到了更好的泛

-

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢