作者:Pieter Delobelle, Ewoenam Kwaku Tokpo, 等

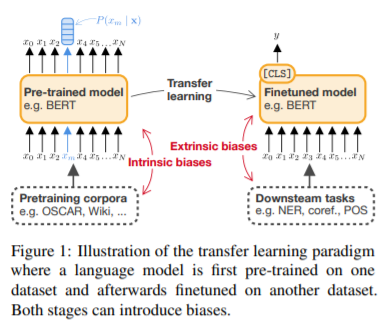

简介:本文是一篇预训练语言模型的量化偏见的综述、作者对公平性度量指标研究并实验评估。随着对自然语言处理资源(如BERT)中的偏见模式的认识不断提高,推动了“偏见”和“公平性”量化指标的研究。但比较不同指标的结果、如何使用这些指标进行评估的工作依然不易。作者调查了关于预训练语言模型的公平性度量的现有文献,并通过实验评估了兼容性,包括语言模型中的两种偏见及其下游任务。作者通过混合传统文献调查和相关分析,以及进行实证评估来做到这一点。作者发现许多指标不兼容,高度依赖于(i)模板,(ii)属性和目标种子,以及(iii)嵌入的选择。实验结果表明,对于语境化的语言模型来说:如非高度主观,则公平性或偏见评估仍然具有挑战性。为改进未来指标的比较和公平性评估,作者建议:避免嵌入基于度量的方法、并将重点放在下游任务中的公平性评估上。

论文下载:https://arxiv.org/pdf/2112.07447.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢