【标题】A Survey on Interpretable Reinforcement Learning

【作者团队】Claire Glanois, Paul Weng, Matthieu Zimmer, Dong Li, Tianpei Yang, Jianye Hao, Wulong Liu

【发表日期】2021.12.24

【论文链接】https://arxiv.org/pdf/2112.13112.pdf

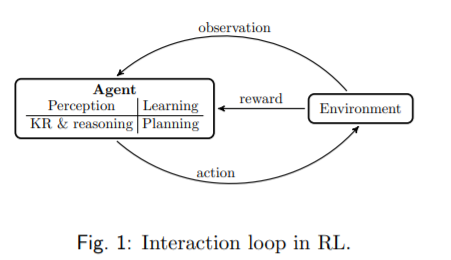

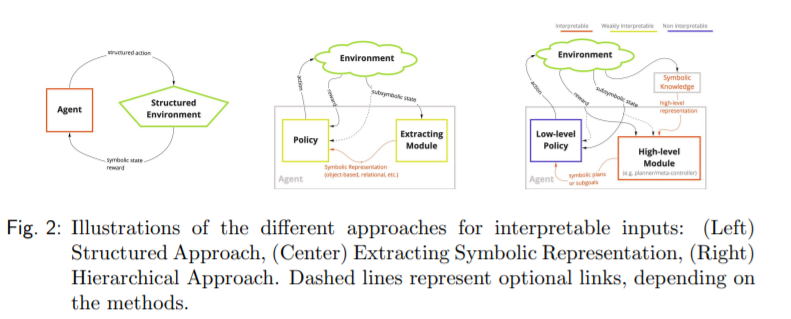

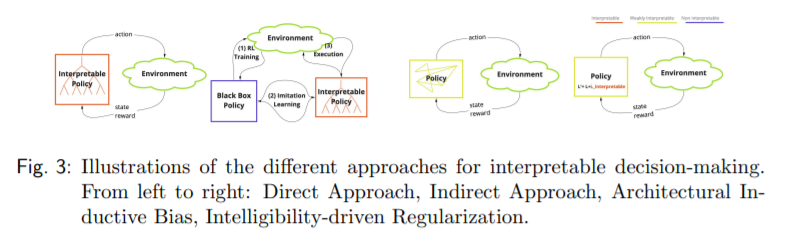

【推荐理由】深度强化学习已成为解决顺序决策问题的一种很有前途的机器学习方法,但对于自主驾驶或医疗应用等高风险领域,深度强化学习还不够成熟。在此情况下,学习到的策略需要是可解释的,以便在任何部署之前对其进行检查(例如,出于安全和可验证的原因)。本研究综述了在强化学习(RL)中实现更高解释性的各种方法。为此,本文区分了可解释性(作为模型的一个属性)和可解释性(作为一个临时操作,在智能体的干预下),并在RL的上下文中讨论它们。本文认为可解释的RL可能包含不同的方面:可解释的输入、可解释的(转换/奖励)模型和可解释的决策。基于此方案,研究总结和分析了最近与可解释RL相关的研究工作,重点是过去10年发表的论文。本文最后还简要讨论了一些相关的研究领域,并指出了一些潜在的有前途的研究方向。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢