本文提出了DAT:Deformable Attention Transformer,这是一种新颖的分层视觉ViT,可适用于图像分类和密集预测任务,表现SOTA!性能优于Swin等网络,代码将开源!

单位:清华大学(黄高团队), AWS AI, 北京智源

代码:https://github.com/LeapLabTHU/DAT

论文:https://arxiv.org/abs/2201.0052

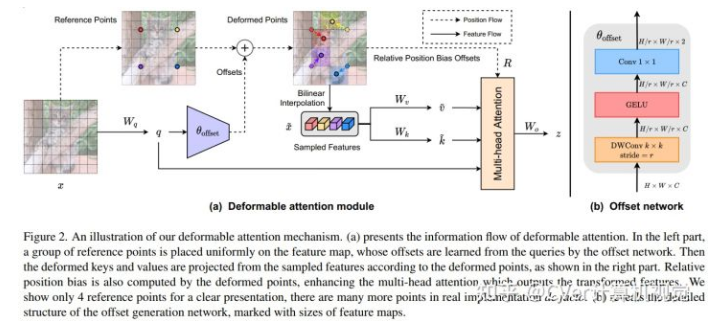

Transformer最近在各种视觉任务上表现出卓越的性能。巨大的,有时甚至是全局的,感受野赋予 Transformer 模型比 CNN 模型更高的表示能力。然而,简单地扩大感受野也会引起一些担忧。一方面,使用密集注意力,例如在 ViT 中,会导致过多的内存和计算成本,并且特征可能会受到超出感兴趣区域的无关部分的影响。另一方面,PVT 或 Swin Transformer 中采用的稀疏注意力与数据无关,可能会限制对远程关系建模的能力。

为了缓解这些问题,我们提出了一种新颖的可变形自注意力模块,其中以数据相关的方式选择自注意力中键和值对的位置。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢