论文标题:

RLNF: Reinforcement Learning based Noise Filtering for Click-Through Rate Prediction

论文链接:

https://dl.acm.org/doi/pdf/10.1145/3404835.3463012

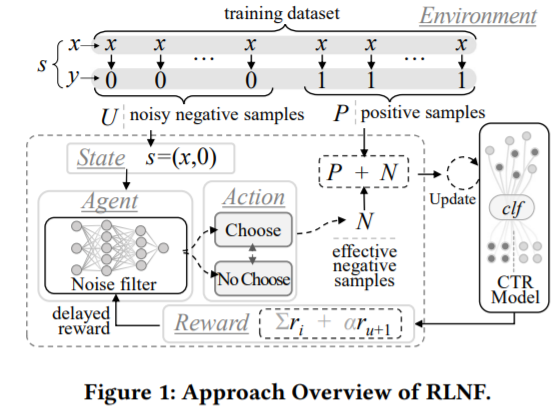

本文可以看做是负样本筛选方面的一篇文章,主要是考虑到直接采用未点击的样本作为负样本会存在许多的噪声,利用强化学习从原始的负样本中筛选出有效的负样本用于提升ctr模型的性能。

如图所示为模型的总体流程,该方法以PULNS[1]为基础,以噪声过滤器为agent,ctr模型和正负样本数据集(U,P)为环境。主要分为两步:噪声过滤器增强和ctr模型增强。

-

第一阶段,噪声过滤器遍历包含噪声的负样本数据集U,对于其中的每个样本,以其特征x为输入,输出为动作(决定是否为有效负样本),然后环境基于动作返回奖励,利用基于策略梯度的方式更新噪声过滤器

-

第二阶段,得到更新后的噪声过滤器选出有效样本的集合N,然后用N和P来增强ctr模型。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢