标题:复旦、中南|Black-Box Tuning for Language-Model-as-a-Service(语言模型即服务的黑盒调优)

作者:Tianxiang Sun, Yunfan Shao, Xipeng Qiu等

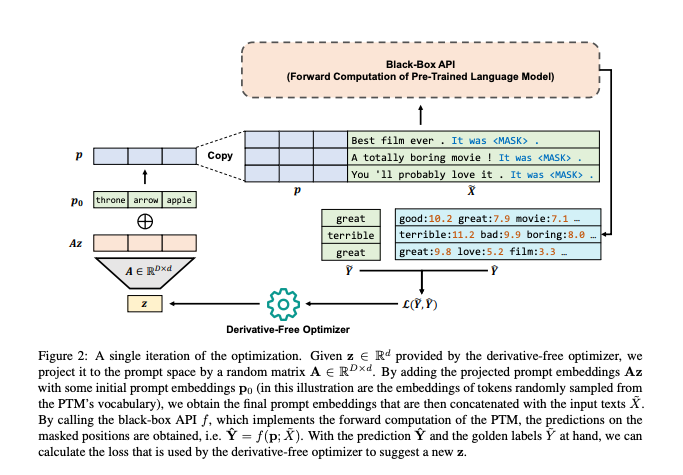

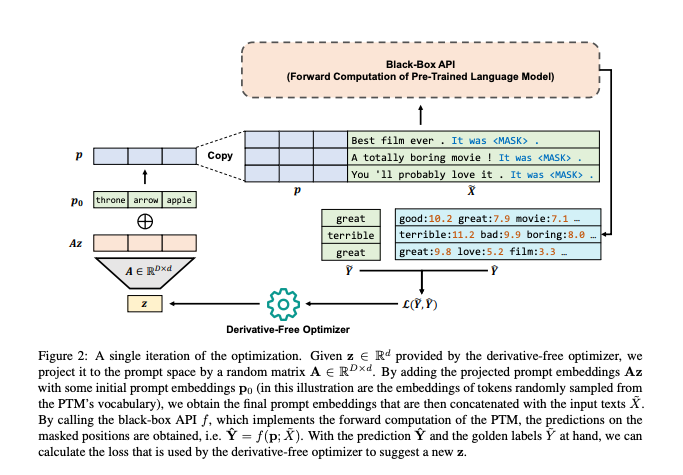

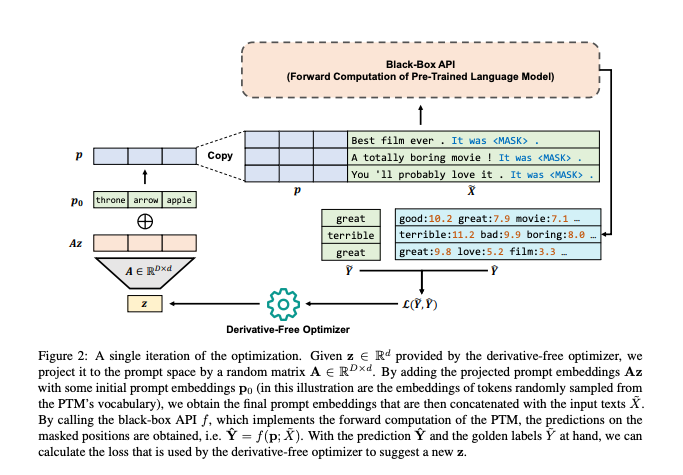

简介:本文介绍了大模型调优的方法。超大型预训练语言模型(PTM),例如 GPT-3,通常会作为一项服务发布,允许用户设计特定于任务的提示以通过一些黑盒API方式查询PTM。在这样的场景下,作者称之为语言模型即服务,但PTM 的梯度通常是无法使用。作者可以仅通过访问模型推理 API 来提示优化任务吗? 根据最近的观察,大型PTM具有非常低的固有维度,这项工作提出了Black-Box通过无导数算法进行调整以优化PTM。 特别是,作者通过迭代调用PTM推理API,在输入文本之前添加连续提示调用CMA-ES优化。作者的实验结果表明,在小标记样本上使用RoBERTa进行黑盒调优不仅显著优于prompt手动调优和GPT-3的上下文学习,也超越了基于梯度的同行,即快速调优和全模型调优。

代码下载:https://github.com/txsun1997/Black-Box-Tuning

论文下载:https://arxiv.org/pdf/2201.03514v1.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢