作者:Tianxiang Sun,Yunfan Shao,Hong Qian,等

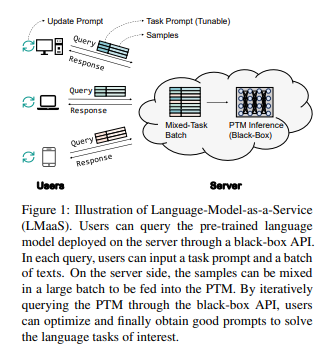

简介:GPT-3等超大的预训练语言模型通常作为服务发布,允许用户设计特定于任务的提示、通过黑盒API来查询预训练模型。在这种场景中,作者称之为语言模型即服务(Language-Model-as-a-Service,即:LMaaS),预训练模型的梯度通常是不可获取的。能否仅通过访问模型推理API来优化任务的Prompt提示呢?基于最近观察到的大型预训练语言模型具有非常低的内在维度,本工作提出了通过无导数算法优化预训练语言模型的黑盒调整。特别是,作者调用“协方差矩阵自适应进化策略”(Covariance Matrix Adaptation Evolution Strategy:CMA-ES),通过迭代调用预训练语言模型推理API来优化输入文本之前的连续提示。作者的实验结果表明,在一些标记样本上使用RoBERTa进行的黑盒调优:不仅显著优于手动提示与GPT-3的上下文学习,而且还优于基于梯度的对应方法,即提示调优和全模型调优。

论文下载:https://arxiv.org/pdf/2201.03514.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢