论文标题:

Invariant Information Bottleneck for Domain Generalization

论文链接:

https://arxiv.org/abs/2106.06333

摘要:

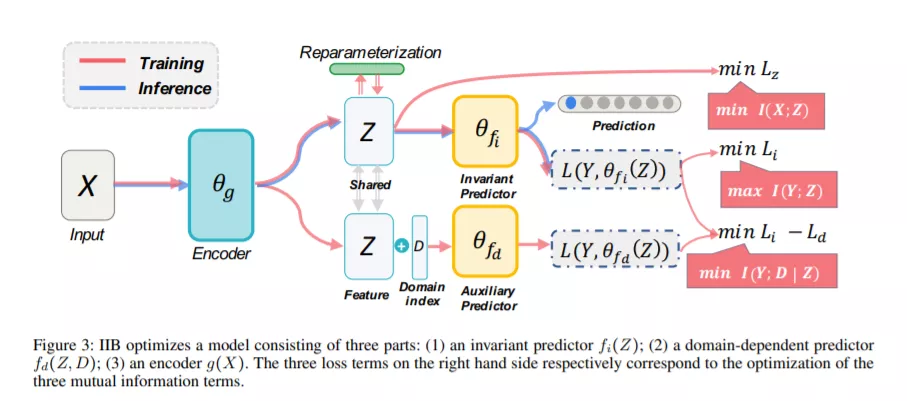

一致风险最小化(IRM)是近年来出现的一种很流行的领域泛化方法。然而,对于非线性分类器来说,IRM 的损失函数很难优化,当伪一致特征(pseudo-invariant feature)和几何偏置(geometric-skews)存在时,通常会导致 IRM 的优化目标失效。以解决 IRM 的缺陷为出发点,本文提出了一种新的领域泛化算法,称为一致性信息瓶颈(IIB)。我们首先提出通过优化互信息的方式实现基于因果关系的一致性预测。然后我们采用互信息的变分形式来建立非线性分类器的可优化的损失函数。其次我们提出最小化输入与特征表示之间的互信息来避免特征表示存在伪一致特征(pseudo-invariant feature)和几何偏置(geometric-skews)。在人工设计的合成数据集上,IIB 的性能显著优于 IRM,在真实数据集 DomainBed 上的实验表明, IIB 在 7 个真实数据集上平均比 13 个基线方法性能高出 0.9%。

贡献:

分析了 IRM 所存在的缺陷,在 IRM 的基础上引入了信息瓶颈(Information Bottleneck),将优化目标整体写成互信息的形式并且采用变分推断优化互信息项。

评论

沙发等你来抢