作者:Tianyi Tang, Junyi Li, Wayne Xin Zhao

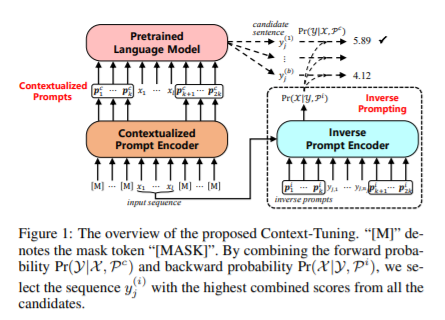

简介:本文是Prompt微调领域的又一创新。最近,预训练语言模型(PLM)在语言生成方面取得了非凡的成功。为了利用PLMs编码的丰富知识,一个简单而强大的机制是以离散标记或连续嵌入的形式使用提示Prompts 。在现有研究中,手动提示耗时且需要领域专家,而连续提示通常独立于输入。为了解决这个问题,作者提出了一种新的连续提示方法:Context-Tuning,用于微调PLM生成自然语言。首先,根据输入的文本导出提示,以便从PLM中获取有用的知识进行生成。作者将此类提示称为语境化提示。其次,为了进一步增强生成的文本与输入的相关性,作者利用连续反向提示,通过建模从输出到输入的反向生成过程来细化自然语言生成过程。此外,作者又提出了一种轻量级的Context-Tuning,只微调0.4%的参数、同时可以保持良好的性能。

论文下载:https://arxiv.org/pdf/2201.08670.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢