作者:Yifan Hou, Guoji Fu, Mrinmaya Sachan

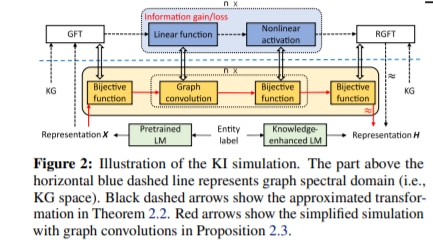

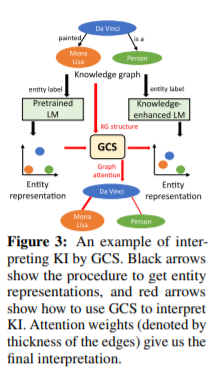

简介:本文属于预训练模型中的知识集成研究领域。预训练语言模型(LMs)不能很好地捕捉事实知识。这导致了许多知识整合(KI)方法的发展,这些方法旨在将外部知识整合到预先训练的LMs中。尽管KI方法比普通LMs有一些性能提升,但这些方法的内部工作原理还不清楚。例如,目前尚不清楚如何以及什么样的知识被有效地整合到这些模型中,以及这种整合是否会导致对已学知识的灾难性遗忘。本文用信息论的观点重新审视了这些模型中的KI过程,并表明可以用图卷积运算来解释KI。作者提出了一个Graph Convolution Simulator的探测模型(GCS) ,用于解释知识增强LMs,并揭示哪些知识集成到这些模型中。作者进行实验,以验证作者的GCS确实可以用于正确解释KI过程,并使用它分析了两个众所周知的知识增强LMs:ERNIE和K-Adapter,发现其中只整合了少量事实知识。作者根据不同的关系类型对知识进行分层,发现ERNIE和K-Adapter在不同程度上整合了不同类型的知识。作者的分析还表明,仅仅增加KI语料库的大小可能不会带来更好的KI;可能需要取得根本性进展。

论文下载:https://arxiv.org/pdf/2202.00964.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢