标题:微软、英伟达|Using DeepSpeed and Megatron to Train Megatron-Turing NLG 530B, A Large-Scale Generative Language Model(使用 DeepSpeed 和 Megatron 训练 Megatron-Turing NLG 5300亿,一种大规模生成语言模型)

作者:Shaden Smith, Mostofa Patwary等

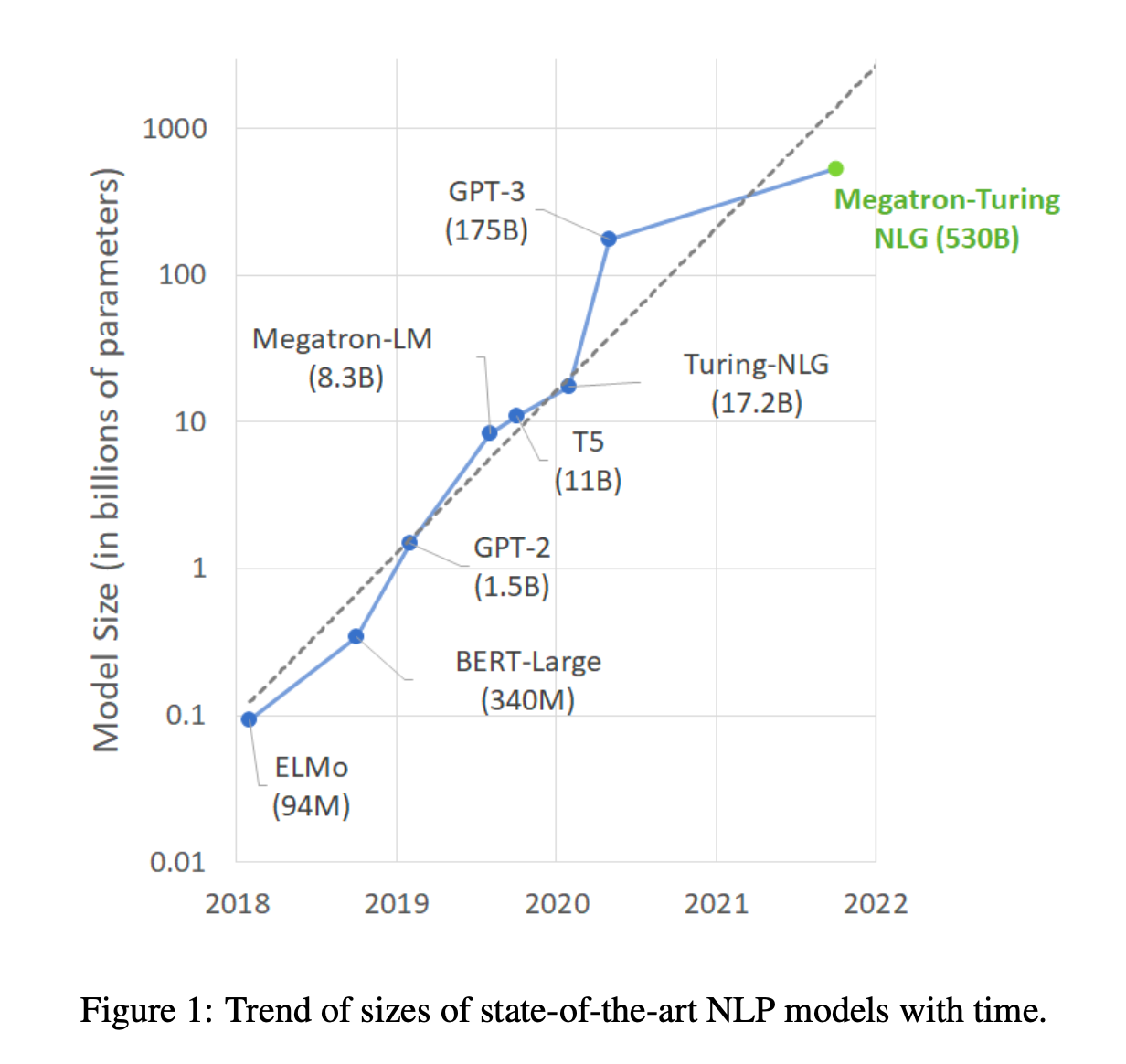

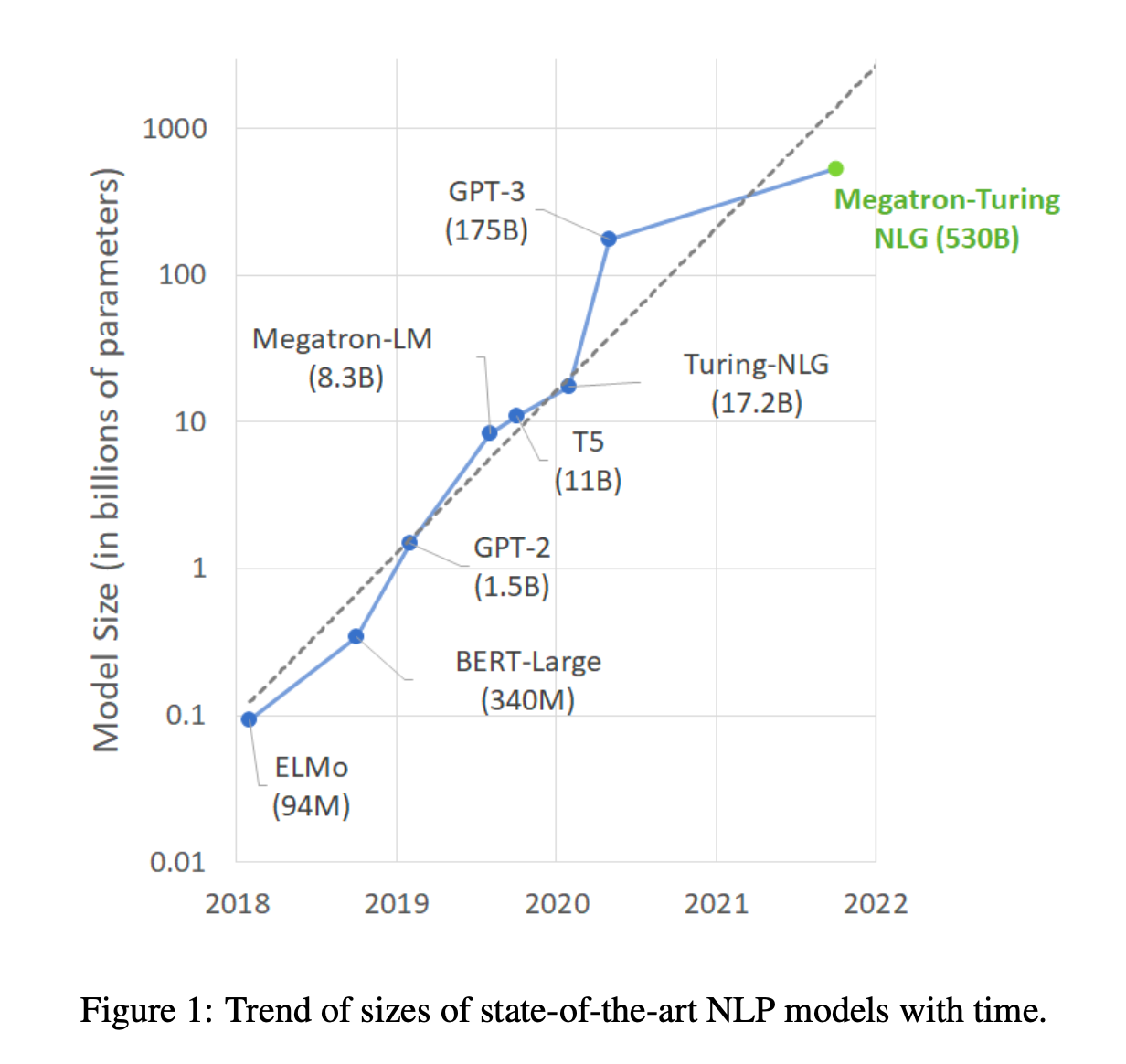

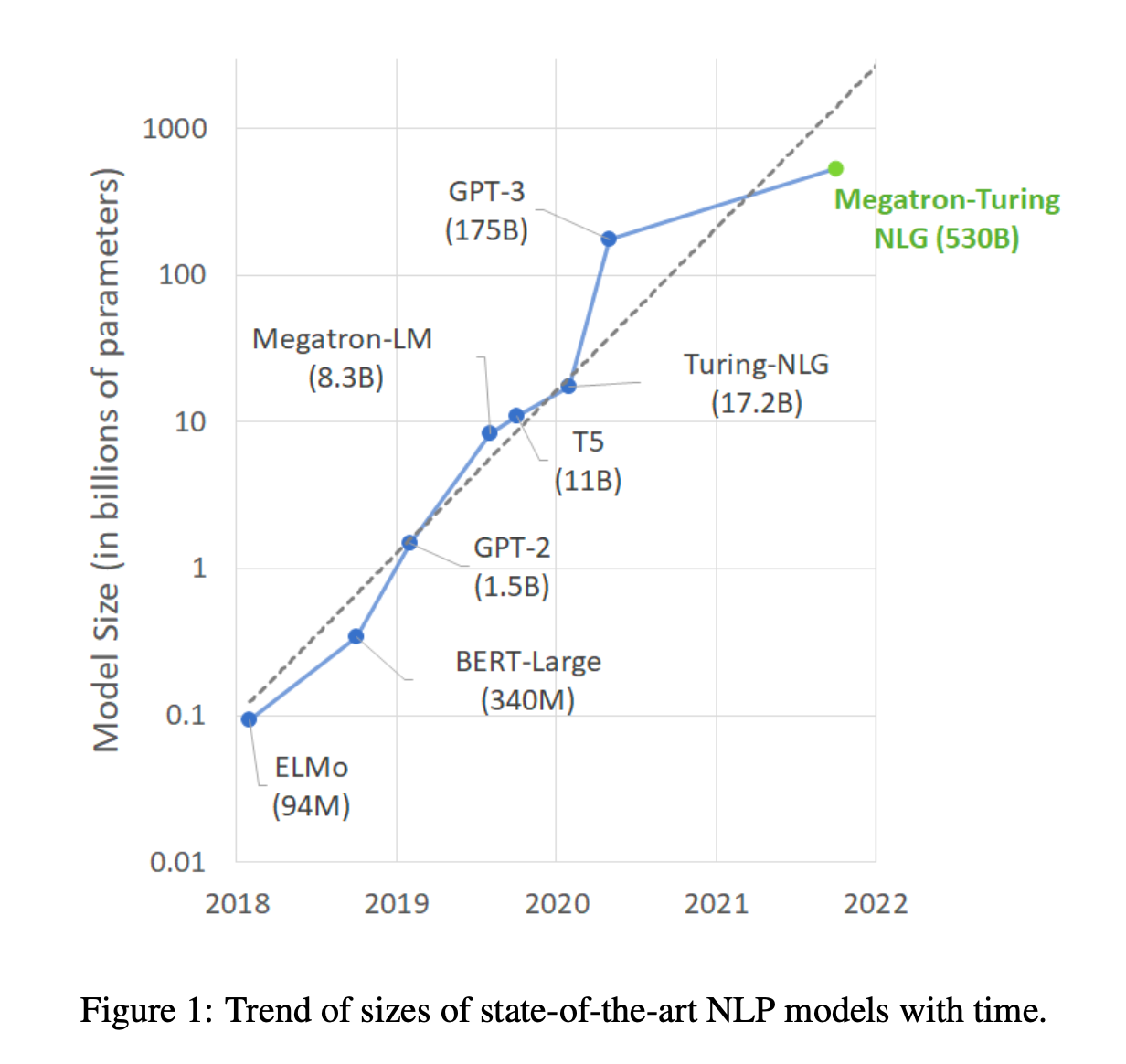

简介:本文介绍了一种文本生成大模型。预训练的通用语言模型可以通过零样本、少样本和微调技术适应下游任务,从而在各种自然语言处理领域实现最先进的精度。由于它们的成功,这些模型的规模迅速增加,需要高性能的硬件、软件和算法技术来训练如此大的模型。作为 Microsoft 和 NVIDIA 共同努力的结果,作者展示了最大的基于巨型变换器的语言模型 Megatron-Turing NLG 530B (MT-NLG) 的训练细节,该模型具有 5300 亿个参数。在本文中,作者首先关注基础设施以及用于使用 DeepSpeed 和 Megatron 训练该模型的 3D 并行方法。接下来,作者详细介绍了训练过程、训练语料库的设计和数据管理技术,作者认为这是模型成功的关键因素。最后,作者讨论了各种评估结果,以及其他有趣的观察结果和 MT-NLG 展示的新特性。作者证明了 MT-NLG 在几个 NLP 基准上实现了卓越的零、一和少样本学习精度,并建立了新的最先进的结果。作者相信作者的贡献将有助于进一步发展大规模训练基础设施、大规模语言模型和自然语言生成。

论文下载:https://arxiv.org/pdf/2201.11990.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢