作者:Guy D. Rosin, Kira Radinsky

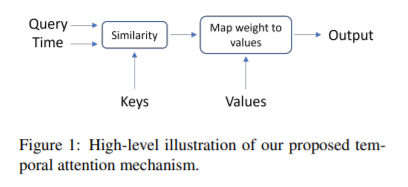

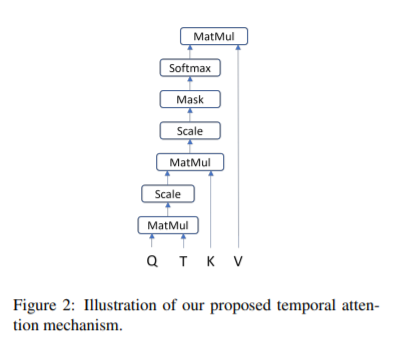

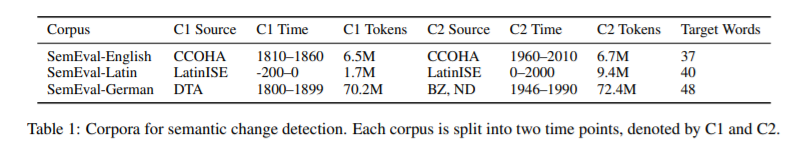

简介:本文研究将时间感知应用在预训练语言模型Attention机制上的创新。基于transformer架构的预训练语言模型在NLP中取得了巨大成功。文本训练数据通常来自网络,因此带有特定于时间的信息,但大多数语言模型忽略了这些信息。他们只接受文本数据的训练,限制了他们在时间上的概括能力。在这项工作中,作者扩展了transformer架构的关键组件:自我注意机制,并提出了时间注意机制——一种时间感知的自我注意机制。时间注意机制可以应用于任何transformer模型,并要求输入文本与其相关的时间点。它允许transformer捕获这些时间信息,并创建特定于时间的上下文化单词表示。作者利用这些表示进行语义变化检测;作者将提出的机制应用于BERT,并在不同语言(英语、德语和拉丁语)的、并且在时间/大小/体裁三个维度上均有所不同的三个数据集上进行实验 。作者提出的模型在所有数据集上都达到了SOTA的结果。

论文下载:https://arxiv.org/pdf/2202.02093.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢