作者:Yu Meng, Jiaxin Huang ,Yu Zhang,Jiawei Han

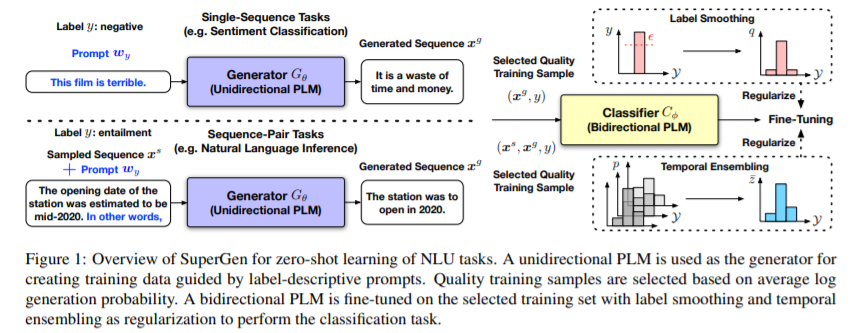

简介:本文综合运用两类不同的预训练语言模型进行零样本学习的探索。预训练语言模型 (PLM) 在各种自然语言处理任务中表现出卓越的性能: 单向 PLM(例如 GPT)以其卓越的文本生成能力而闻名;双向 PLM(例如BERT)一直是自然语言理解(NLU)任务的主要选择。虽然这两种类型的模型都取得了有希望的小样本学习性能,但它们在零样本学习方面的潜力尚未得到充分开发。在本文中,作者提出了一种简单的方法,该方法使用两种类型的 PLM 对 NLU 任务进行完全零样本学习,而不需要任何特定于任务的数据:单向 PLM 生成由提示引导的类条件文本,用作训练用于微调双向 PLM 的数据。

论文下载:https://arxiv.org/pdf/2202.04538.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢