【标题】Understanding Value Decomposition Algorithms in Deep Cooperative Multi-Agent Reinforcement Learning

【作者团队】Zehao Dou, Jakub Grudzien Kuba, Yaodong Yang

【发表日期】2022.2.10

【论文链接】https://arxiv.org/pdf/2202.04868.pdf

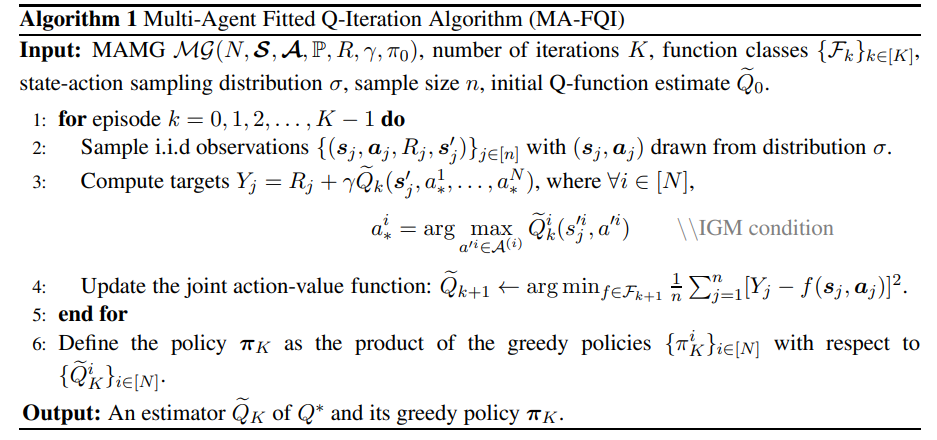

【推荐理由】价值函数分解正在成为合作博弈中扩展多智能体强化学习(MARL)的常用经验法则。为使此类分解规则成立,必须假设单个全局最大值(IGM)原则;即每个智能体的分解值函数上的局部最大值必须等于联合值函数上的全局最大值。然而,这一原则并不一定要普遍适用。因此,值分解算法的适用性被隐藏,其相应的收敛性仍然未知。本文首先尝试回答这些问题,其引入了一组合作对策,其中的值分解方法是有效的,称之为可分解对策。在可分解博弈中,本文从理论上证明了应用多智能体适配Q-迭代算法(MA-FQI)将得到最优Q-函数。在不可分解对策中,在每次迭代时Q函数需要投影到可分解函数空间的情况下,MA-FQI估计的Q函数仍然可以收敛到最优。在这两种设置中,本文考虑值函数表示通过实际的深度神经网络,并得出其相应的收敛速度。本文的结果首次为MARL从业者提供了价值分解算法何时收敛以及为何表现良好的理论见解。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢