【标题】Settling the Communication Complexity for Distributed Offline Reinforcement Learning

【作者团队】Juliusz Krysztof Ziomek, Jun Wang, Yaodong Yang

【发表日期】2022.2.10

【论文链接】https://arxiv.org/pdf/2202.04862.pdf

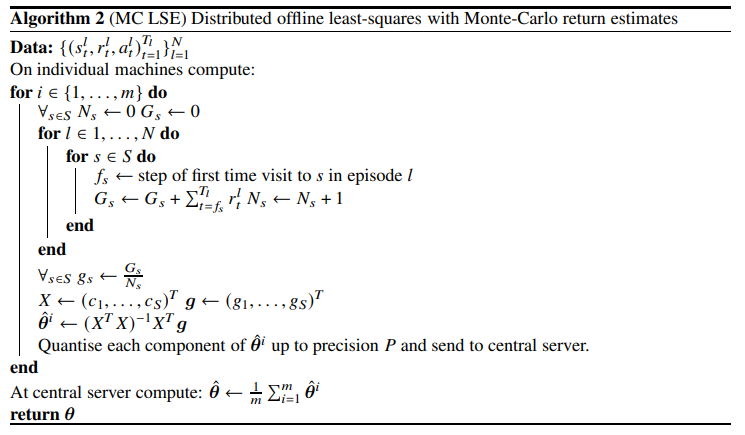

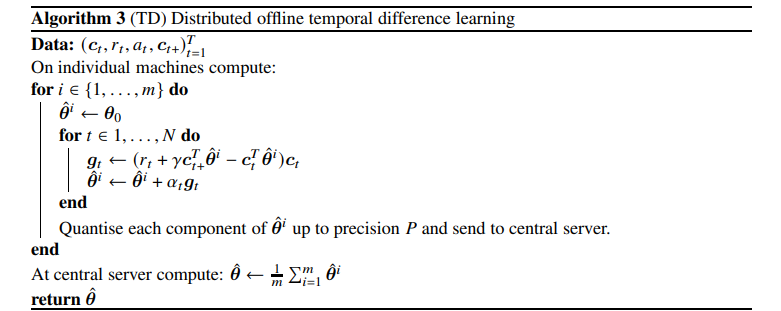

【推荐理由】本文研究了离线强化学习 (RL) 中的一种新设置,其中许多分布式机器联合协作解决问题,但只允许单轮通信,并且每台机器可以发送的信息总数(以比特为单位)存在预算约束。对于上下文bandits中的价值函数预测,以及偶发和非偶发 MDP,本文建立了分布式统计估计的极大极小风险的信息论下界;这揭示了任何离线 RL 算法所需的最小通信量。具体来说,对于上下文强盗,研究表明比特数必须至少按比例缩放Ω ( AC)匹配集中的极小极大最优率,其中A是动作的数量和C是上下文维度;同时,在 MDP 设置中也得到了类似的结果。此外,本文提出了基于最小二乘估计和蒙特卡洛回报估计的学习算法,并提供了一个清晰的分析,表明它们可以实现对数因子的最佳风险。此外,该研究还表明,由于该方法的初始偏差,时间差异无法在单轮通信设置下有效地利用来自所有可用设备的信息。据研究所知,本文提出了分布式离线 RL 问题的第一个极小极大下界。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢