作者:Jun Xia, Yanqiao Zhu, Yuanqi Du, Stan Z. Li

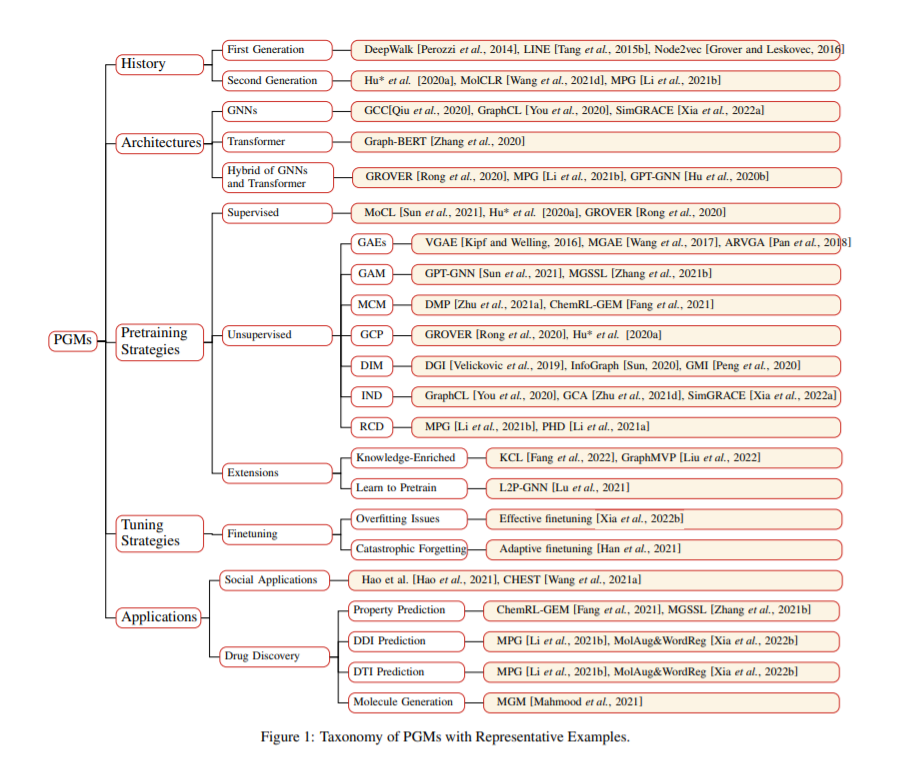

简介:像BERT这样的预训练语言模型(PLM)已经彻底改变了自然语言处理(NLP)的格局。受其扩散的启发,人们对预训练图模型(PGM)进行了大量的研究。由于PGMs强大的模型架构,可以从大量标记和未标记的图形数据中获取丰富的知识。隐式编码在模型参数中的知识可以使各种下游任务受益,并有助于缓解图学习的几个基本问题。在这篇论文中,作者提供了第一个全面PGMs的综述。作者首先介绍了图表示学习的局限性,然后介绍了图预训练的动机。然后,根据分类法从四个不同的角度对现有PGM进行了系统分类。接下来,作者介绍PGMs在社交推荐和药物发现方面的应用。最后,作者概述了多个有前途的研究方向、作为未来研究的指导参考。

论文下载:https://arxiv.org/pdf/2202.07893

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢