作者:Canwen Xu, Julian McAuley

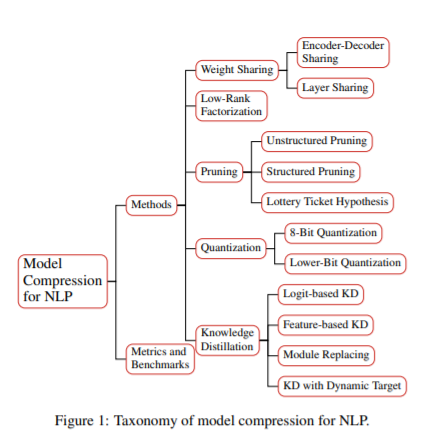

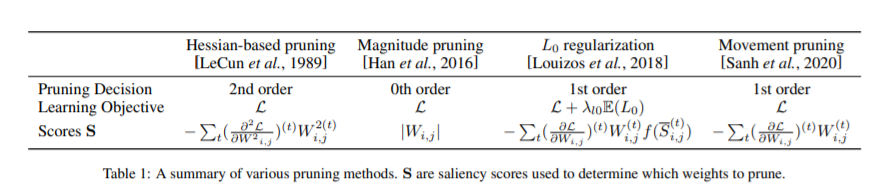

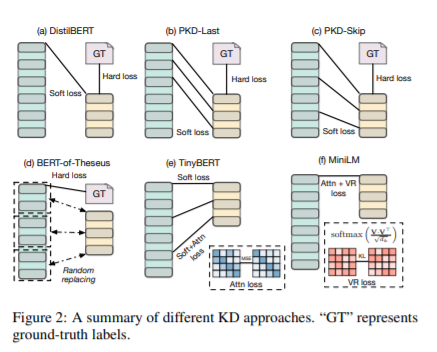

简介:随着Transformer 和预训练技术等新体系结构的发展,自然语言处理(NLP)的应用取得了重大进展。然而,Transformer的高能耗和长推理延迟阻碍了NLP进入更广泛的场景,包括边缘和移动计算。有效的NLP研究的目的是全面考虑计算,时间和碳排放的整个生命周期的NLP,包括数据准备,模型训练和推理。在本次综述中,作者将重点放在推理阶段,并回顾NLP模型压缩的现状,包括基准、指标和方法,最后作者还概述了目前的障碍和未来的研究方向。

论文下载:https://arxiv.org/pdf/2202.07105

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢