作者:Canwen Xu, Julian McAuley

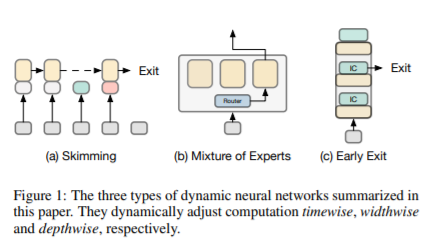

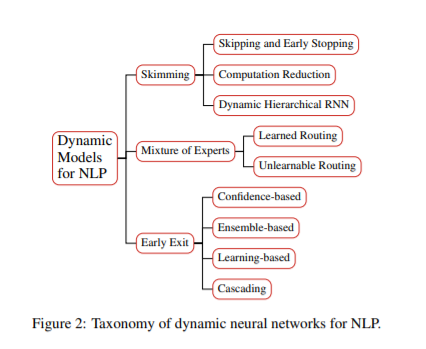

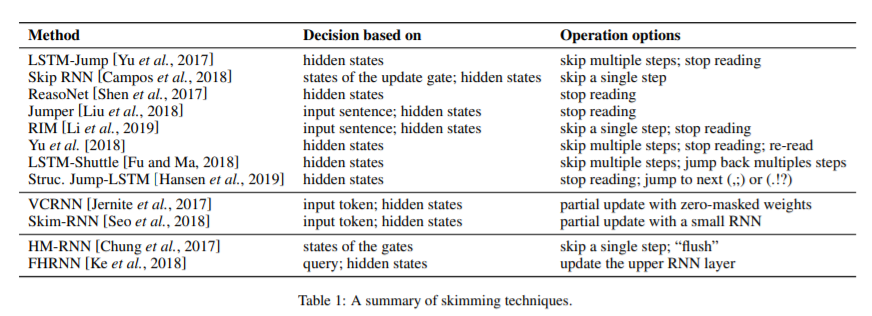

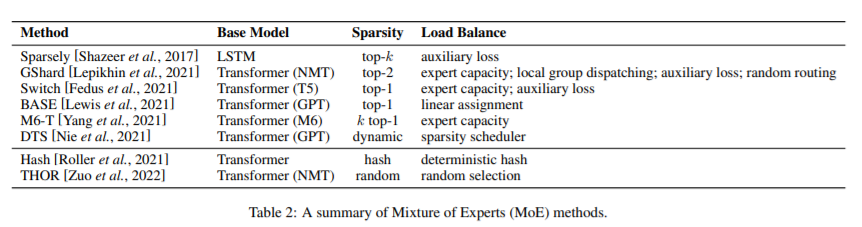

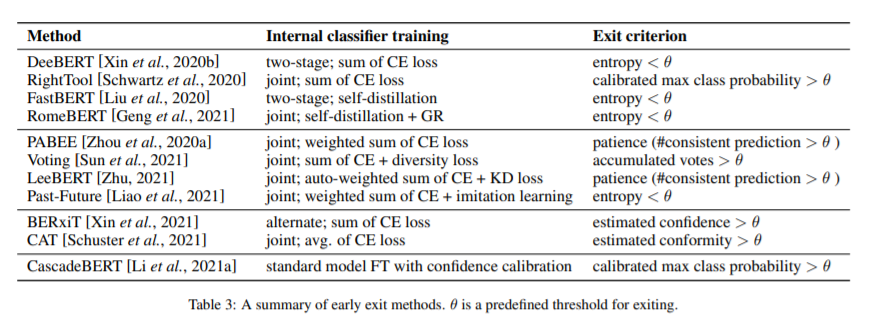

简介:有效地缩放大型Transformer 模型是自然语言处理最新进展的主要驱动力。动态神经网络是一个新兴的研究方向,它能够根据输入动态调整神经网络的计算路径,从而在计算量和时间上实现亚线性增长。动态神经网络可能是一个很有希望的解决方案,可以解决不断增长的预训练语言模型的参数数量,既可以使用数万亿个参数进行模型预训练,又可以在移动设备上进行更快的推理。在这篇综述中,作者总结了三种动态神经网络在自然语言处理中的进展:略读(skimming)、混合专家模型(mixture of experts)和早期退出推理(early exit)。作者还强调了动态神经网络目前面临的挑战和未来研究的方向。

论文下载:https://arxiv.org/pdf/2202.07101.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢