近日,朱松纯教授团队在Cell子刊《iScience》上发表了题为《Counterfactual explanations with theory of-mind for enhancing human trust in image recognition models》的论文。

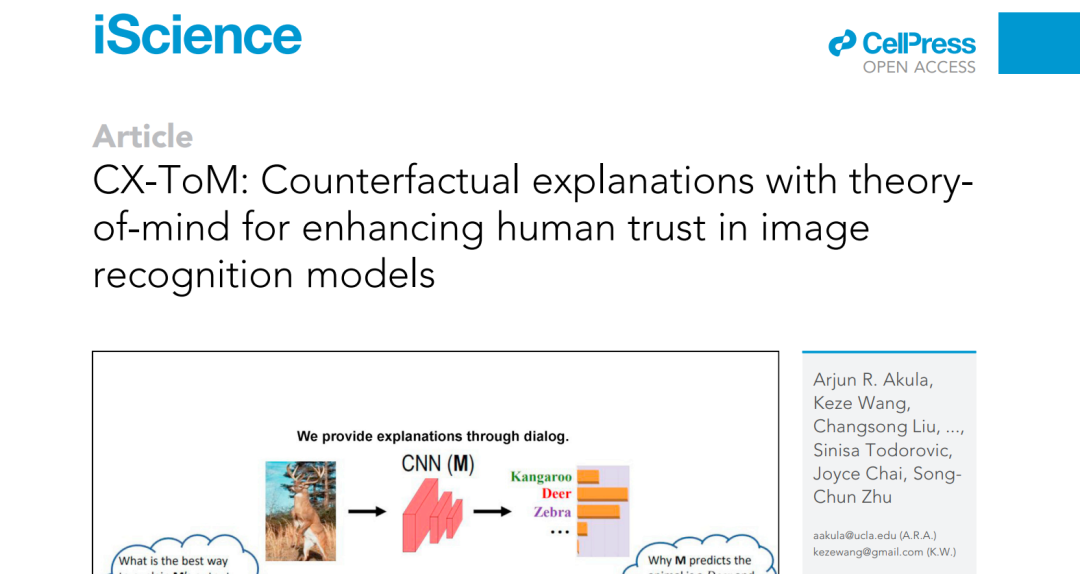

这篇论文提出了一个新的可解释AI框架CX-ToM,它将“心智理论(ToM)”和“反事实解释”(counterfactual explanations)集成到了单一的解释框架中,可以用于解释深度卷积神经网络(CNN)做出的决策,在图像识别模型中增强人类对神经网络的信任。

当前可解释AI框架倾向于在单轮对话中生成“解释”,是一锤子买卖,而本文的一大亮点则是将“解释”视为一种基于人机交互对话的多轮次通信过程。

论文地址:

https://www.cell.com/iscience/fulltext/S2589-0042(21)01551-0

朱松纯团队曾于2019年发表论文《X-ToM: Explaining with Theory-of-Mind for Gaining Justified Human Trust》。X-ToM模型使用心智理论(ToM)增加了人类对AI的信任,CX-ToM模型是在X-ToM模型的基础上最新融合运用了反事实解释(Counterfactual explanations)的概念,进一步增加了人类对AI的信任。

X-ToM论文地址:

https://arxiv.org/abs/1909.06907

尽管基于大数据训练的神经网络模型在这两年已经发展到了成千上万亿的参数规模,但是其内部的演算机制仍然无法解释,在获取人类的信任方面效果甚微。而CX-ToM模型却能增加人类对图像识别神经网络的信任,这里的关键在于,CX-ToM模型将“反事实解释”(CX)和“心智理论(ToM)”集成融合到了单一的解释框架中,反事实解释和心智理论都是使得神经网络获取人类信任的功臣。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢