论文标题:Visual Attention Network

论文链接:https://arxiv.org/abs/2202.09741

代码链接:https://github.com/Visual-Attention-Network

作者单位:清华大学 & 南开大学

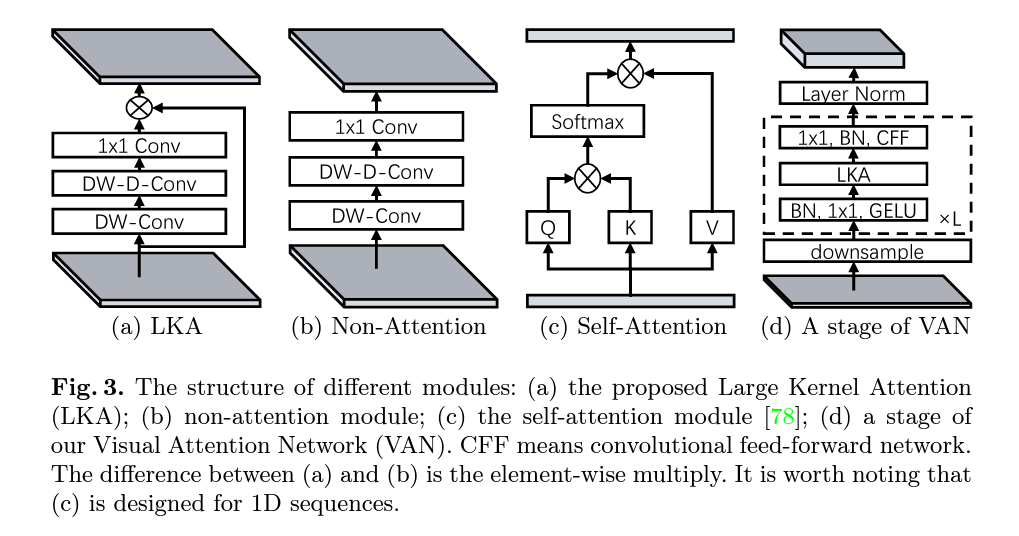

虽然最初是为自然语言处理 (NLP) 任务设计的,但自注意力机制最近已经席卷了各种计算机视觉领域。然而,图像的 2D 特性为在计算机视觉中应用自注意力带来了三个挑战。 (1) 将图像视为一维序列会忽略它们的二维结构。 (2) 二次复杂度对于高分辨率图像来说太昂贵了。 (3) 只捕捉空间适应性而忽略通道适应性。在本文中,我们提出了一种新颖的大核注意力(LKA)模块,以实现自我注意力中的自适应和长期相关性,同时避免上述问题。我们进一步介绍了一种基于 LKA 的新型神经网络,即视觉注意网络(VAN)。虽然非常简单和高效,但 在广泛的实验(包括图像分类、对象检测、语义分割、实例分割等领域, VAN以较大的优势胜过最先进的视觉转换器和卷积神经网络。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢