【标题】Reward-Free Policy Space Compression for Reinforcement Learning

【作者团队】Mirco Mutti, Stefano Del Col, Marcello Restelli

【发表日期】2022.2.22

【论文链接】https://arxiv.org/pdf/2202.11079.pdf

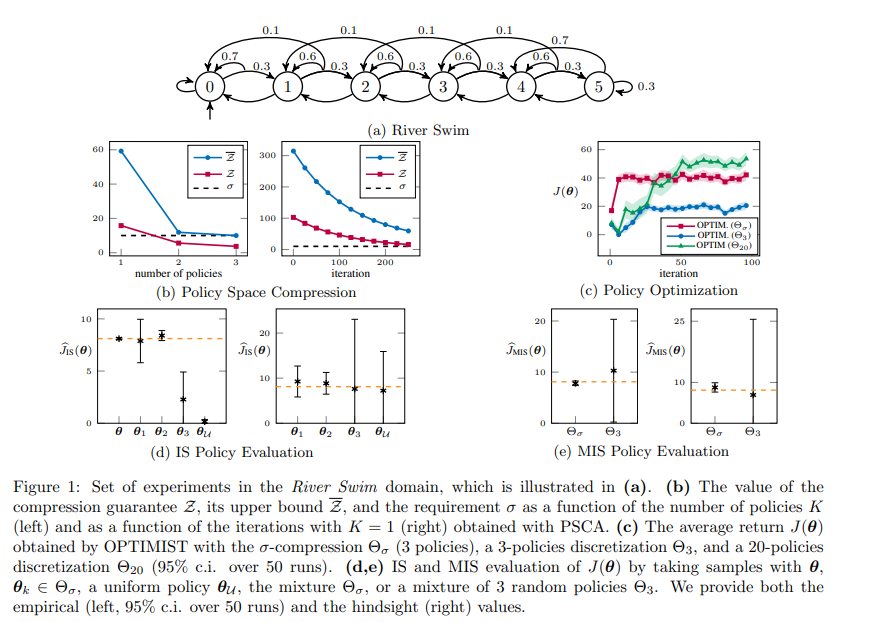

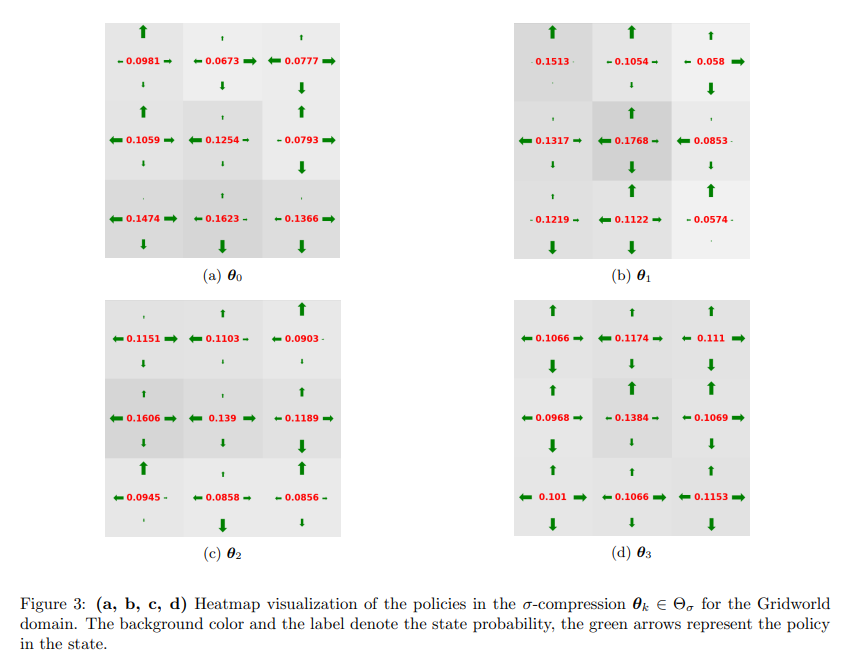

【推荐理由】在强化学习中,本文将与环境交互的agent的潜在行为编码为无限的策略集,即策略空间,通常由一系列参数函数表示。处理这样的策略空间是一项艰巨的挑战,其通常会导致样本和计算效率低下。然而,当考虑到环境的结构和策略参数化时,有限数量的策略实际上是相关的,因为它们中的许多会引发非常相似的交互,即状态-动作分布。本文寻求将策略空间无奖励压缩为一组有限的代表性策略,这样,给定任何策略π,代表性策略的状态行为分布和π的状态行为分布之间的最小Rényi散度是有界的。研究表明这种策略空间的压缩可以表述为一个集合覆盖问题,它本质上是NP难的。尽管如此,本文提出了一种博弈论重构,通过迭代拉伸压缩空间以覆盖敌对策略,可以有效地找到局部最优解。最后,本文提供了一个实证评估来说明简单域中的压缩过程及其在强化学习中的连锁反应。

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢