作者:Chuhan Wu, Fangzhao Wu, Tao Qi, 等

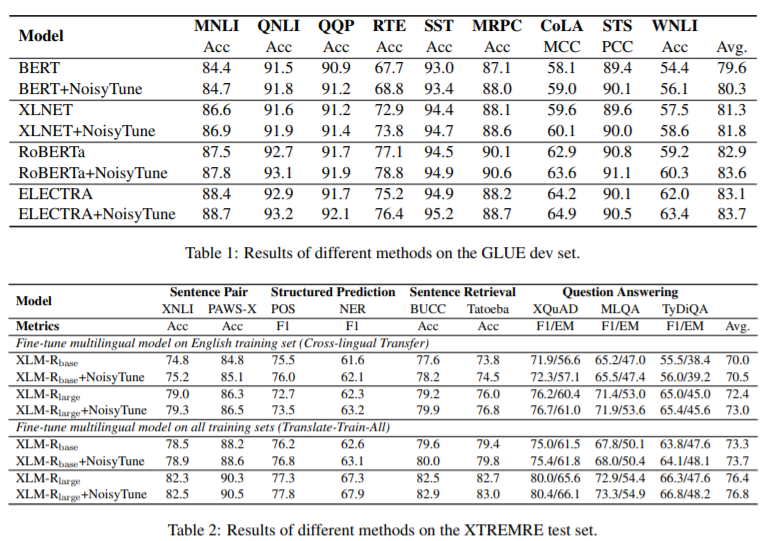

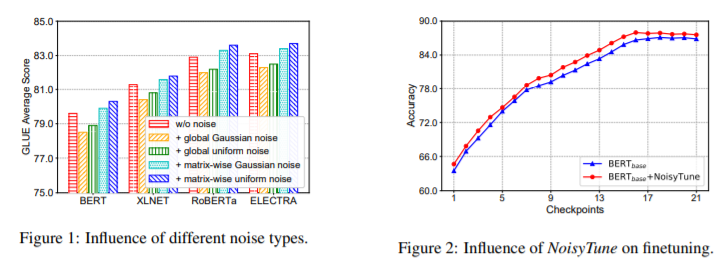

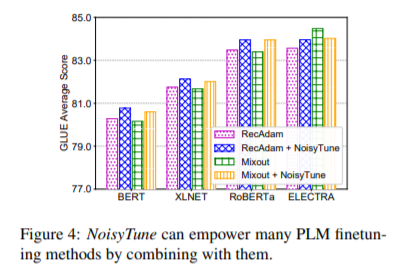

简介:本文研究噪音数据对预训练语言模型微调的影响。有效地微调,对于预训练语言模型(PLM)在下游任务中的成功至关重要。然而,PLM可能存在过度拟合训练前信号的风险,并且下游任务和训练前任务之间存在一些差距。普通的微调方法很难克服预训练和下游任务之间的障碍,这会导致性能不理想。在本文中,作者提出了一种非常简单但有效的方法NoiseyTune,可以通过在微调前向PLM的参数添加一些噪声来帮助更好地微调下游任务中的PLM。更具体地,作者根据不同参数矩阵的标准偏差,提出了一种矩阵均匀扰动方法,该方法可以兼顾PLMs中不同类型参数的变化特性。在GLUE English基准测试和XTREME多语言基准测试上进行的大量实验表明,NoisyTune可以在许多下游任务中持续提高不同PLM的性能。

论文下载:https://arxiv.org/pdf/2202.12024.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢