标题:麦考瑞大学、微软|PromDA: Prompt-based Data Augmentation for Low-Resource NLU Task(PromDA:基于提示的低资源NLU数据增强)

作者:Yufei Wang,Can Xu, Daxin Jiang等

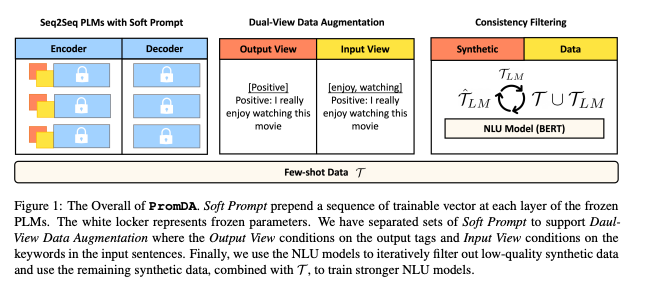

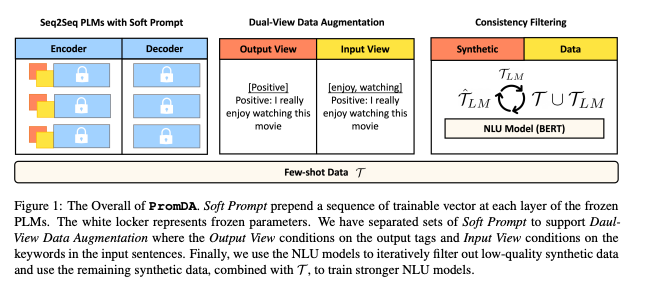

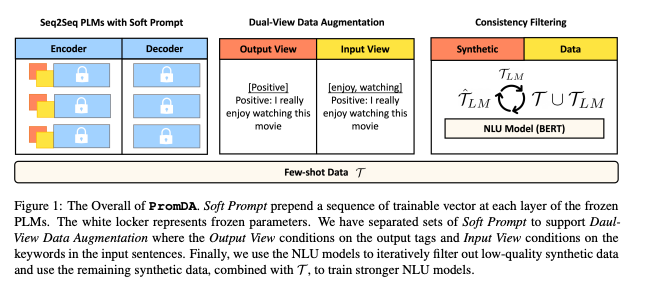

简介:本文提出一种低资源自然语言理解任务的数据增强方法。作者提出了在冻结预训练语言模型 (PLM)下,基于提示的数据增强模型(PromDA)只训练小规模的软提示(即一组可训练的向量)。这避免人工收集未标记的域内数据并保持生成的合成数据的质量。此外,PromDA通过两个不同的生成合成数据使用 NLU 模型查看并过滤掉低质量的数据。四个基准的实验表明,由PromDA成功提升了NLU模型的性能,这些模型始终优于几个竞争基线模型,包括最先进的半监督模型使用未标记的域内数据。这来自PromDA的合成数据也与未标记的域内数据互补,这NLU模型可以进一步改进他们结合起来进行训练。

论文下载:https://arxiv.org/pdf/2202.12499.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢