标题:英特尔|TRIMBERT: TAILORING BERT FOR TRADE-OFFS(TRIMBERT:为权衡取舍量身定制BERT)

作者:Sharath Nittur Sridhar, Anthony Sarah, Sairam Sundaresan

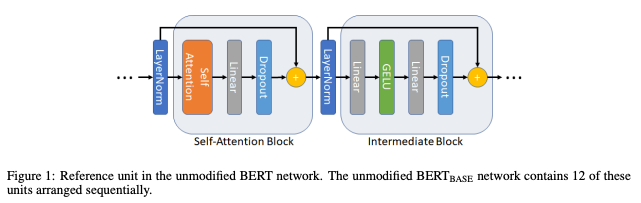

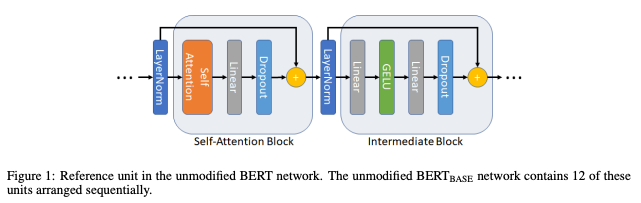

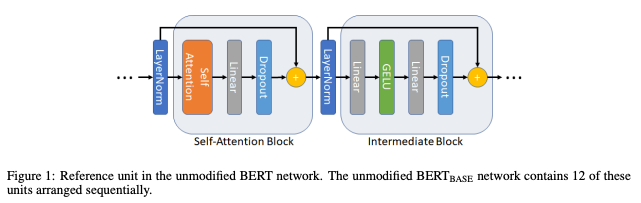

简介:本文介绍了一种新的BERT网络结构改进。基于BERT 的模型在解决各种自然语言问题上已经处理(NLP)任务非常成功。不幸的是,许多这些大型模型需要大量的计算资源和/或时间来进行预训练和微调,这限制了更广泛的可采用性。尽管自注意力层已经过充分研究,这是包含中间层的有力理由跟随它们的层在文献中仍然缺失。在这项工作中,作者表明减少BERT-BASE中的中间层数量导致下游任务的微调精度损失最小,同时显着减少模型大小和训练时间。作者进一步减轻了两个关键瓶颈,通过用计算更简单的替代方法替换自注意层中的所有softmax操作并删除所有layernorm操作的一半。 这进一步减少训练时间,同时保持高水平的微调精度。

论文下载:https://arxiv.org/pdf/2202.12411.pdf

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢