论文题目:Differentiable Prompt Makes Pre-trained Language Models Better Few-shot Learners

![]()

随着自然语言处理技术的不断发展,大模型预训练微调已成为了标准范式,并在大量的语言理解、问答等基准数据集和领域任务上取得了显著的突破。然而,在预训练和微调的过程中,不同阶段的优化目标不一致。为了解决这一问题,OpenAI等机构开始探索使用大规模预训练语言模型如GPT、BERT等的新思路,通过给定提示词(Prompt)和少量样本实例来应用大模型,并发展出一种全新的自然语言处理范式----“提示学习”。

提示学习通过构造提示模板和标签映射,统一了预训练目标和微调任务,进而提升了语言模型的少样本、跨领域、多任务等能力。提出学习最早起源于GPT3[1]、T5等大模型,并由PET[2,3]、LM-BFF[4]发扬光大。后续工作也在这一时期如雨后春笋般涌现,如清华大学提出了可自动学习模版的方法P-tuning[5]、知识增强提示学习方法PTR[6]、预训练提示方法PPT[7],斯坦福大学提出了可学习前缀式提示学习方法Prefix-tuning[8],Huggingface提出了T0[9]多任务学习方法等。相关工作可以参见https://github.com/thunlp/PromptPapers以及CCF关于提示学习的术语解读[10]

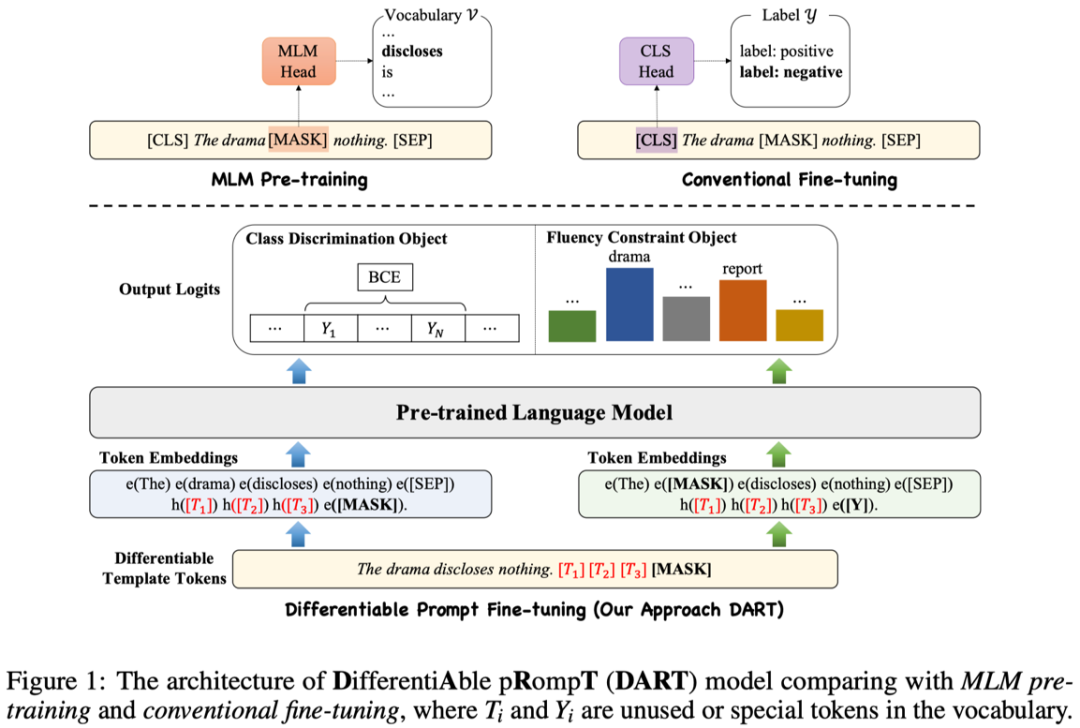

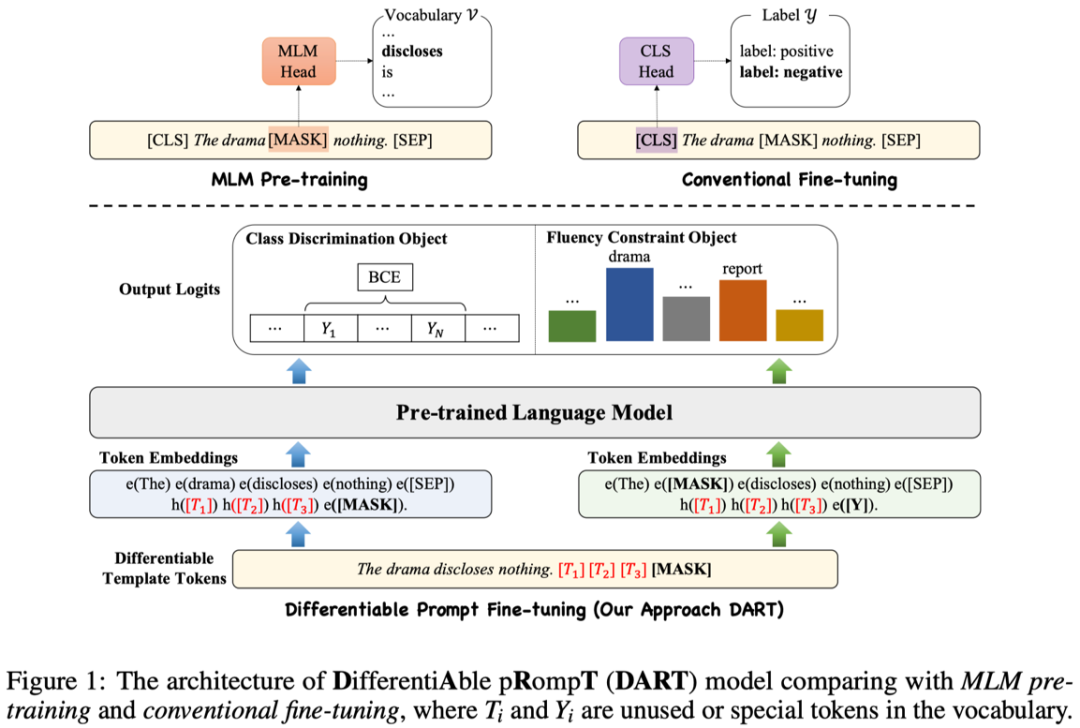

提示学习通过引入任务相关的模版和标签映射,将分类任务优化目标转换为和语言模型预训练过程中掩码文本建模(Masked-Language Modeling)目标相一致的形式。其中如何选取合适模版和标签映射是影响提示学习性能的关键。从PET的手工构建模版方式,到AutoPrompt和LM-BFF等工作基于梯度或者生成模型选取离散模版词,再到P-tuning引入外部架构并从任务中学习连续化模版词,可以看出提示学习的工作经历了从离散到连续、从手工到自动的演进过程,类似于人工智能领域从特征工程到深度学习的范式变化。有鉴于离散化模版词的非最优性,本文提出的DART(DifferentiAble pRompT)方法采用了一种简单的构造方式,可以在任务中同时学习连续化的模版和标签映射。

具体而言,本文提出的方法使用一类特殊的非语义词元作为模版和标签映射词,并在训练过程对这些词元的表示进行优化:

![]()

在训练过程中,首先对分类目标进行训练: 。此外,DART还引入了和预训练过程类似的流畅度目标(Fluency Constraint Object),对每个样本随机选取词元进行遮盖并预测,训练损失为 。DART结合两方面损失进行训练: 。

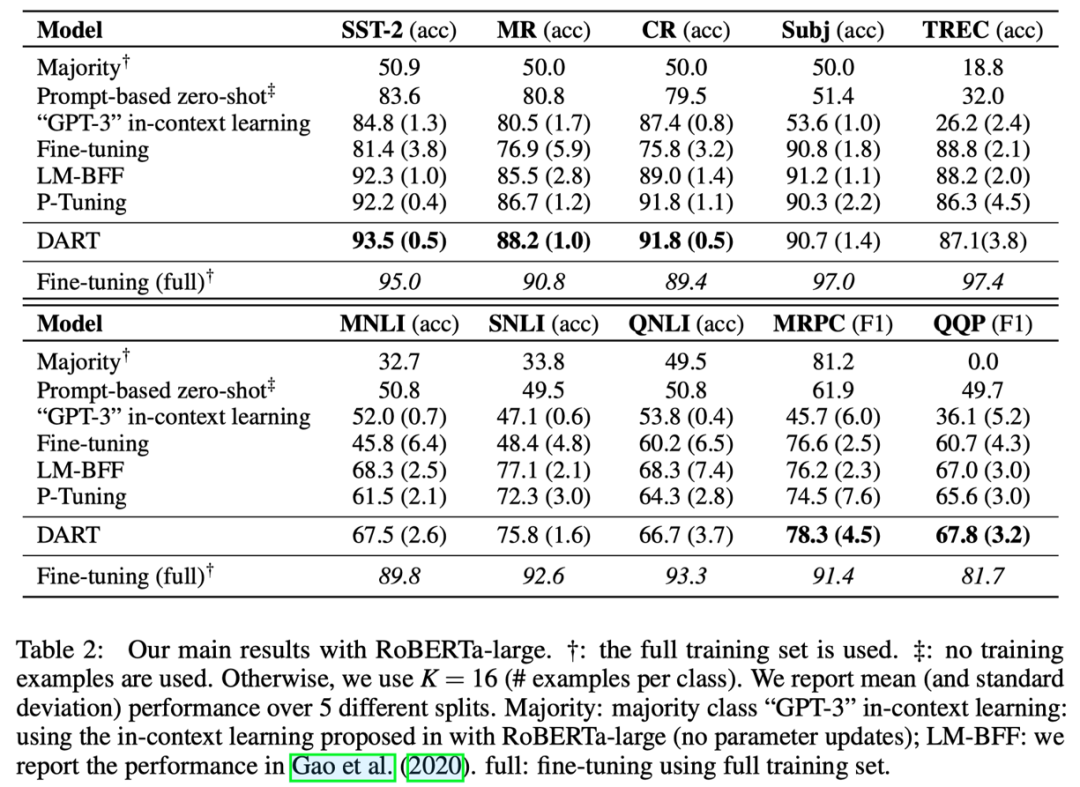

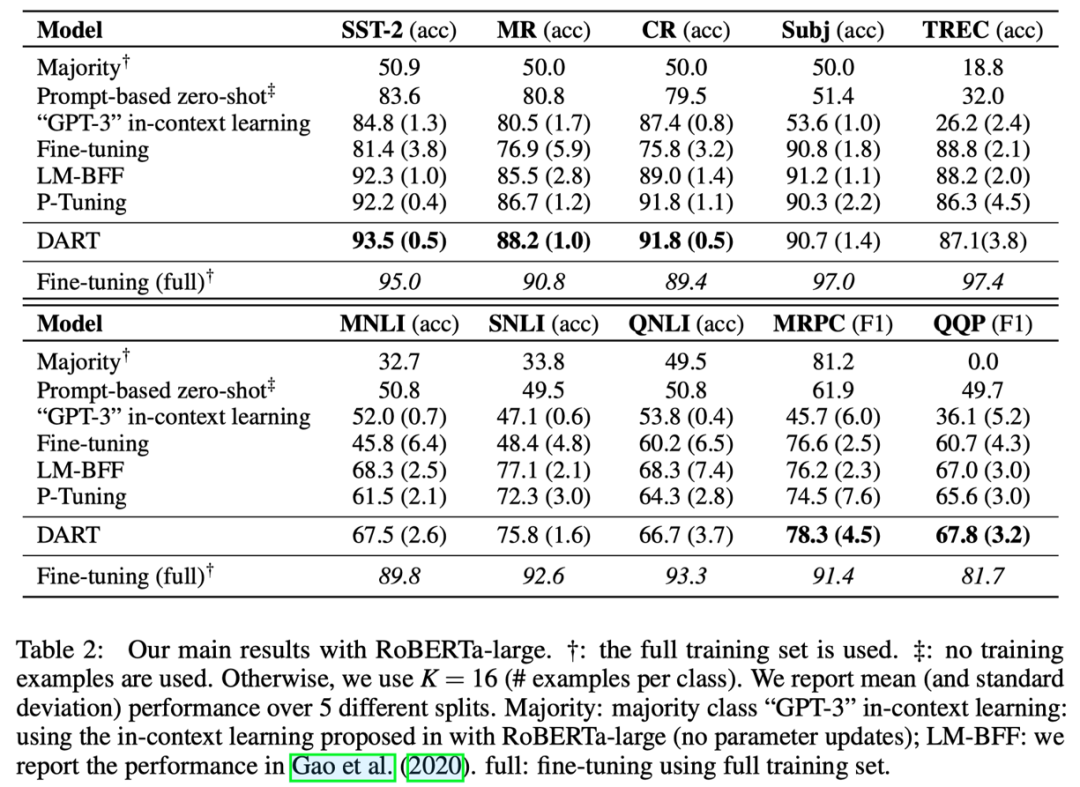

本文列出了DART模型在15个NLP数据集上的表现,包括情感分析、自然语言推理、释义、句子相似度、关系抽取和事件抽取的多种任务,其中涵盖主流的句子分类数据集如SST-2、MR、CR、Subj、TREC、MNLI、QNLI、MRPC和QQP等,以及多种关系/事件抽取数据集如SemEval 2010、TACRED-Revisit、Wiki80、Chemprot、ACE2005等,并与现有工作进行了对比。以下表格列出了主要的实验结果,具体的实验结果和分析可以参见论文。

![]()

本文介绍了DART,一种简单而有效的提示学习方法,可以在一定程度上提升预训练语言模型的样本利用效率。与传统的微调方法相比,DART可以在少样本情形降低提示构建成本和提升任务性能,并可拓展到其他语言模型和任务。

[1] Brown T, Mann B, Ryder N, et al. Language models are few-shot learners[J]. Advances in neural information processing systems, 2020, 33: 1877-1901.

[2] Schick T, Schütze H. It's not just size that matters: Small language models are also few-shot learners[J]. arXiv preprint arXiv:2009.07118, 2020.

[3] Schick T, Schütze H. Exploiting cloze questions for few shot text classification and natural language inference[J]. arXiv preprint arXiv:2001.07676, 2020.

[4] Gao T, Fisch A, Chen D. Making pre-trained language models better few-shot learners[J]. arXiv preprint arXiv:2012.15723, 2020.

[5] Liu X, Zheng Y, Du Z, et al. GPT understands, too[J]. arXiv preprint arXiv:2103.10385, 2021.

[6] Han, Xu, et al. "Ptr: Prompt tuning with rules for text classification." arXiv preprint arXiv:2105.11259 (2021).

[7] Gu Y, Han X, Liu Z, et al. Ppt: Pre-trained prompt tuning for few-shot learning[J]. arXiv preprint arXiv:2109.04332, 2021.

[8] Li X L, Liang P. Prefix-tuning: Optimizing continuous prompts for generation[J]. arXiv preprint arXiv:2101.00190, 2021.

[9] Sanh V, Webson A, Raffel C, et al. Multitask prompted training enables zero-shot task generalization[J]. arXiv preprint arXiv:2110.08207, 2021.

内容中包含的图片若涉及版权问题,请及时与我们联系删除

评论

沙发等你来抢